排序

Spark性能优化总结(建议收藏)

近期优化了一个spark流量统计的程序,此程序跑5分钟小数据量日志不到5分钟,但相同的程序跑一天大数据量日志各种失败。经优化,使用160 vcores + 480G memory,一天的日志可在2.5小时内跑完,下...

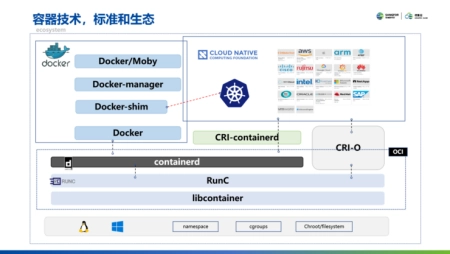

大数据技术学习之Spark技术总结

Spark是基于内存的迭代计算框架,适用于需要多次操作特定数据集的应用场合。需要反复操作的次数越多,所需读取的数据量越大,受益越大,数据量小但是计算密集度较大的场合,受益就相对较小(大数...

每日互动成立大数据联合实验室 助力公共大数据应用创新

本报见习记者吴文文 近日,浙江每日互动网络科技股份有限公司(股票简称:每日互动;股票代码,300766)与浙江省温州市人民政府签署了战略合作协议。作为战略合作的一部分,每日互动与温州市大数...

破题大数据应用难点,TalkingData发布城市大数据场景创新平台

11月25日,T11 2019暨TalkingData数据智能峰会在北京中国大饭店举办。会议期间,TalkingData正式发布“城市大数据场景创新平台”,并与武汉市东湖高新区签订“TalkingData华中研发总部、全国交...

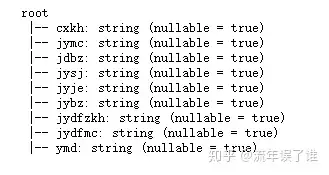

spark—实践之DataSet实战企业人员管理系统应用案例

此案例参考书籍《Spark大数据商业实战三部曲》,特做学习笔记,巩固学习过程。案例预览:给每位员工的年龄增加100给特定的员工年龄增加70,其他增加30对人员信息中的重复数据进行去重按年龄进行...

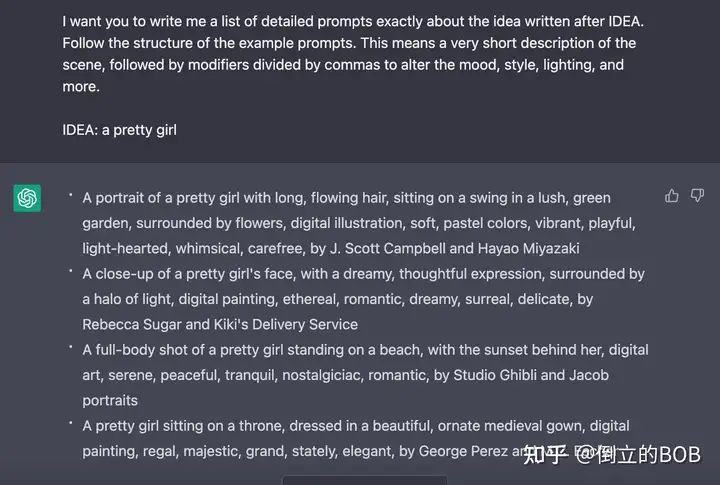

pyspark处理数据基本语法

作为一个和数据相关的专业,想学习pyspark,从而了解并学习pyspark ,以便更好的应用到工作中。 1、连接数据库 import findspark #初始化 findspark.init() import warnings warnings.filterwarn...