排序

代码+案例详解:使用Spark处理大数据最全指南

全文共17984字,预计学习时长30分钟或更长如今,有不少关于Spark的相关介绍,但很少有人从数据科学家的角度来解释该计算机引擎。因此,本文将试着介绍并详细阐述——如何运行Spark?一切是如何...

AI大模型团队Colossal-AI破局创新,火热招募中!

公司简介 潞晨科技致力于解放 AI 生产力,通过高效多维并行、异构内存管理、大规模优化库、自适应任务调度等自研技术,打造面向大模型时代的通用深度学习系统 Colossal-AI ,高效促进 AI 大模型...

大数据人才需求怎么样 Spark技术是怎么回事

大数据人才需求怎么样?Spark技术是怎么回事?Spark是基于内存的迭代计算框架,适用于需要多次操作特定数据集的应用场合。需要反复操作的次数越多,所需读取的数据量越大,受益越大,数据量小但...

spark知识点总结

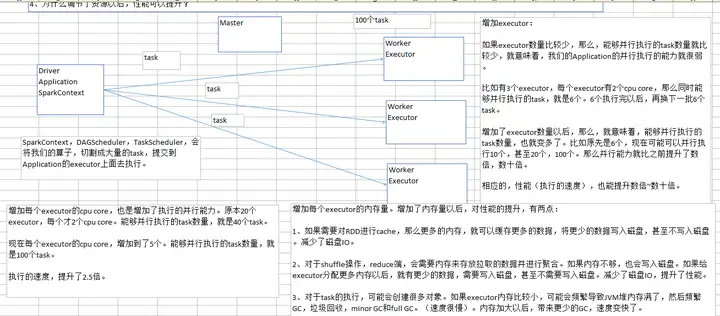

说明:这篇文章是我的一位师兄写的,放上来只为了自己学习时参考,谢谢! 一、性能调优 1、分配资源 a、在我们在生产环境中,提交spark作业时,用的spark-submit shell脚本,里面调整对应的参数...

window环境下安装spark

❝ spark是大数据计算引擎,拥有Spark SQL、Spark Streaming、MLlib和GraphX四个模块。并且spark有R、python的调用接口,在R中可以用SparkR包操作spark,在python中可以使用pyspark模块操作spar...

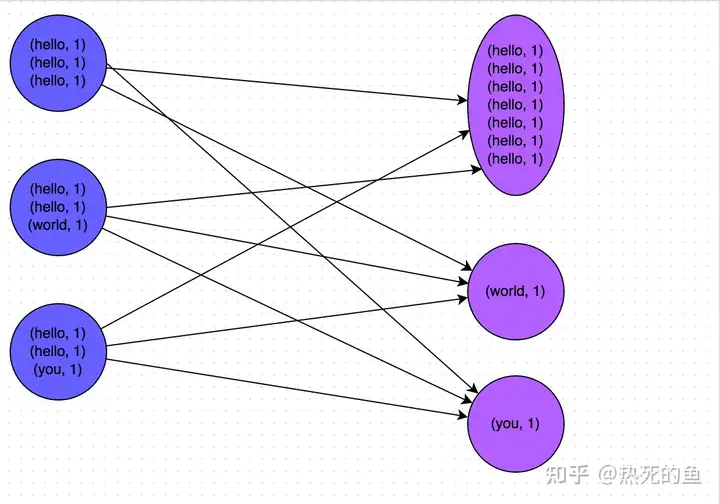

Spark性能优化指南——高级篇

热死的鱼:Spark性能优化指南——基础篇2 赞同 · 1 评论文章 继基础篇讲解了每个Spark开发人员都必须熟知的开发调优与资源调优之后,本文作为《Spark性能优化指南》的高级篇,将深入分析数据倾...