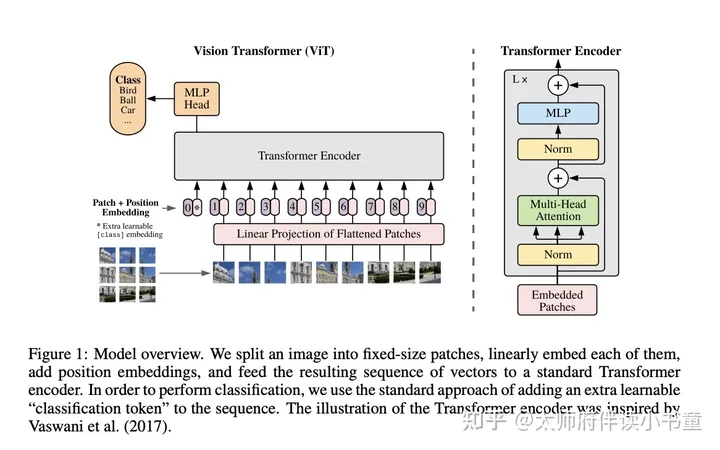

Vision Transformer(ViT):打通CV与NLP领域的经典之作

打通的壁垒 回顾一下,在Transformer中,计算自注意力权重的时候,需要序列中的元素两两计算相似度(或者叫相容性函数),其计算复杂度是 O(n2)O( n^{2} )。所以,如果序列长度太长的话,计算复...

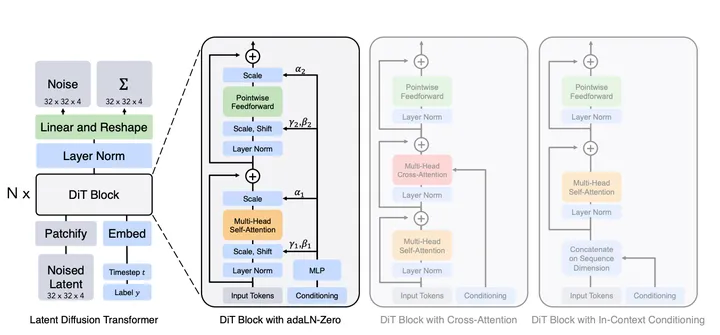

DiT:Transformers 与扩散模型强强联手

出品人:Towhee 技术团队 王翔宇、顾梦佳(@JJJael) 扩散模型在图像生成领域有着难以撼动的地位,而其通常都选择了卷积 U-Net 作为主干模型,那么在其他领域大杀四方的 Transformers 在扩散模...

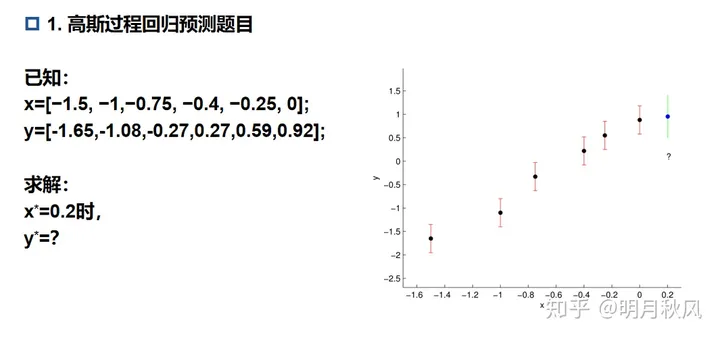

快速入门高斯过程(Gaussian process)回归预测

前言 这篇文章主要是教会你如何快速了解高斯过程进行回归预测的,并没有太多的公式推导,只有简单的相关的概念的介绍,如果您要自己掌握并使用高斯过程进行一个简单的预测,当然还需要进行一些...

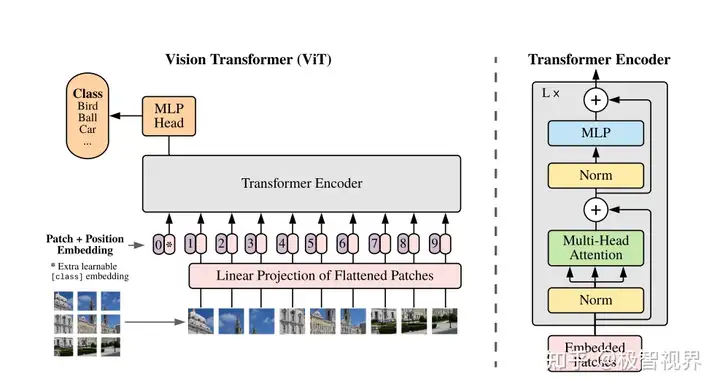

极智AI | 详解 ViT 算法实现

欢迎关注我,获取我的更多笔记分享 大家好,我是极智视界,本文详细介绍一下 ViT 算法的设计与实现,包括代码。 ViT 全称 Vision Transformer,是 transformer 在 CV 领域应用表现好的开始,而...

统治扩散模型的U-Net要被取代了,谢赛宁等引入Transformer提出DiT

来自 UC 伯克利的 William Peebles 以及纽约大学的谢赛宁撰文揭秘扩散模型中架构选择的意义,并为未来的生成模型研究提供经验基线。机器之心报道,编辑:陈萍、蛋酱。 近几年,在 Transformer ...