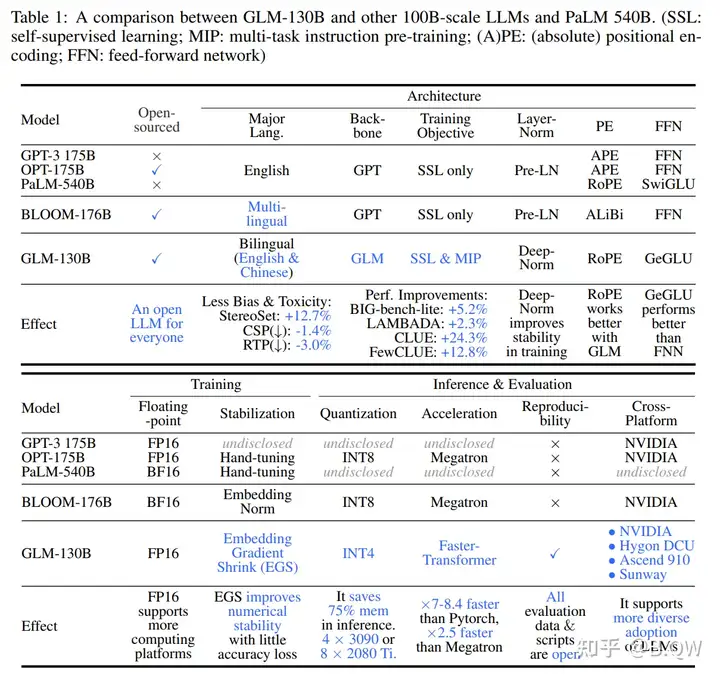

【自然语言处理】【大模型】GLM-130B:一个开源双语预训练语言模型

《GLM-130B: An open bilingual pre-trained model》 论文:https://arxiv.org/pdf/2210.02414.pdf 一、简介 大语言模型(LLMs),特别是参数超过100B的模型呈现出诱人的scaling laws,其会突然...

复旦团队发布国内首个类 ChatGPT 模型 MOSS,将为国内大语言模型的探索和应用带来哪些影响?

复旦放大招:国内首个类ChatGPT来了,名字叫“MOSS”!邀公众参与内测 2023年开年,ChatGPT迅速火遍全球,短短两个月时间月活突破一亿,成为被载入史册的应用之一。 ChatGPT的大火引发了全球科...

超越ImageNet预训练,Meta AI提出SplitMask,小数据集也能自监督预训练

编辑:陈萍 大规模数据集对自监督预训练是必要的吗?Meta AI 认为,小数据集也能自监督预训练,效果还不错。 目前,计算机视觉神经网络被大量参数化:它们通常有数千万或数亿个参数,这是它们成...

5300亿参数的「威震天-图灵」,微软、英伟达合力造出超大语言模型

在微软和英伟达的共同努力下, Turing NLG 17B 和 Megatron-LM 模型的继承者诞生了:5300 亿参数,天生强大,它的名字叫做「Megatron-Turing」。机器之心报道,编辑:蛋酱、小舟。 刚刚,微软和...

加速3.47倍!火山引擎助力AIGC突破性能瓶颈法国第一夫人有多美?看看她与9岁马克龙跳舞的照片,你就知道了

AIGC(AI-Generated Content 人工智能生成内容)一经推出火爆全网,各种画风和产品形态频频出现且快速演进。以Stable Diffusion模型为例,一次完整的预训练大约需要在128张A100计算卡上运行25天...

AI21 Labs构建1780亿参数大语言模型,耗资或达2亿美元,被认为是OpenAI最有力竞争者

目前,大量资金正在流入语言模型开发领域。语言模型是一种能够理解和生成文本的 AI 系统。近几年,该类模型是各大公司的一个关注焦点。像知名 AI 公司 OpenAI 研发的大语言模型 GPT-3 正被成千...