出品人:Towhee 技术团队 王翔宇、顾梦佳(@JJJael)

扩散模型在图像生成领域有着难以撼动的地位,而其通常都选择了卷积 U-Net 作为主干模型,那么在其他领域大杀四方的 Transformers 在扩散模型中是否还有用武之地呢?基于这一想法,DiT(Diffusion Transformer) 利用 transformer 结构探索了一种新的扩散模型。它不仅继承了Transformer模型类的优秀扩展特性,性能还优于先前使用 U-Net 的模型。研究表明,扩散模型可以成功地用 transformer 替换 U-Net 主干。另外,它还证明了网络复杂性与样本质量之间存在很强的相关性。通过简单地扩展 DiT 并训练具有高容量主干的潜在扩散模型,DiT 模型可以在类条件 256 × 256 ImageNet 生成基准上实现 FID 2.27 的最新结果。

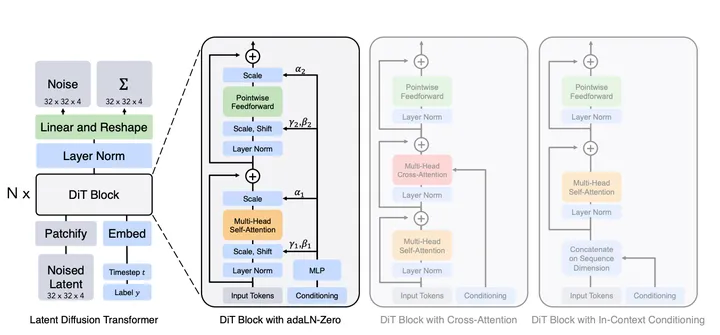

DiT 首先将空间表示输入通过第一层网络,将每个 patch 线性嵌入到输入中,以此将空间输入转换为一个数个 token 序列。然后,模型会将标准的基于 ViT 频率的位置嵌入应用于所有输入 token。接着,输入 token 由一系列 transformer 块处理。除了噪声图像输入之外,扩散模型有时还会处理额外的条件信息,例如噪声时间步长、类标签、自然语言等。DiT 探索了四种transformer 块变体,分别以不同方式处理条件输入 。

相关资料:

代码地址:https://github.com/facebookresearch/DiT论文链接:Scalable Diffusion Models with Transformers更多资料:统治扩散模型的U-Net要被取代了,谢赛宁等引入Transformer提出DiT如果你觉得我们分享的内容还不错,请不要吝啬给我们一些鼓励:点赞、喜欢或者分享给你的小伙伴!

活动信息、技术分享和招聘速递请关注:

如果你对我们的项目感兴趣请关注:

用于存储向量并创建索引的数据库 Milvus用于构建模型推理流水线的框架 Towhee

暂无评论内容