IFQ-Tinier-YOLO

IFQ-Net: Integrated Fixed-point Quantization Networks for Embedded Vision

作者:Hongxing Gao, Wei Tao, Dongchao Wen, Tse-Wei Chen, Kinya Osa, Masami Kato

单位:Canon Information Technology (Beijing) Co., LTD;Device Technology Development Headquarters, Canon Inc.

论文:https://arxiv.org/abs/1911.08076

引用 | 4

时间:2019年11月19日

该工作一部分基于YOLOv2,设计了IFQ-Tinier-YOLO人脸检测器,它是一个定点网络,比Tiny-YOLO减少了256倍的模型大小(246k Bytes)。

![图片[1]-【你只需看一次】YOLO 全系列目标检测算法-卡咪卡咪哈-一个博客](https://pic2.zhimg.com/80/v2-36cb164d306536edf0104d0c629b05f5_720w.webp)

DG-YOLO

WQT and DG-YOLO: towards domain generalization in underwater object detection

作者:Hong Liu, Pinhao Song, Runwei Ding

单位:北大;鹏城实验室

论文:https://arxiv.org/abs/2004.06333

时间:2020年4月14日

该工作旨在研究水下目标检测数据,因为水下目标的数据比较少,提出了新的水质迁移的数据增广方法和YOLO新变种:DG-YOLO ,该算法由 YOLOv3, DIM 和 IRM penalty 组成。

![图片[2]-【你只需看一次】YOLO 全系列目标检测算法-卡咪卡咪哈-一个博客](https://pic3.zhimg.com/80/v2-61be06b313ec24e7caf5753b7971959a_720w.webp)

Poly-YOLO

Poly-YOLO: higher speed, more precise detection and instance segmentation for YOLOv3

作者:Petr Hurtik, Vojtech Molek, Jan Hula, Marek Vajgl, Pavel Vlasanek, Tomas Nejezchleba

单位:奥斯特拉发大学;Varroc Lighting Systems

论文:https://arxiv.org/abs/2005.13243

解读:mAP提升40%!YOLO3改进版—— Poly-YOLO:更快,更精确的检测和实例分割

代码:https://gitlab.com/irafm-ai/poly-yolo

时间:2020年5月27日

基于YOLOv3,支持实例分割,检测mAP提升40%!

![图片[3]-【你只需看一次】YOLO 全系列目标检测算法-卡咪卡咪哈-一个博客](https://pic3.zhimg.com/80/v2-2fbd88c48b399b8a0bb4d307bae8cd32_720w.webp)

文章目录

一、概述二、Yolo系列全家桶YOLOv1 开山鼻祖之作YOLOv2YOLOv3YOLOv4 目标检测tricks集大成者YOLOv5Fast YOLOComplex-YOLOMV-YOLOYOLO3DYOLO-6DYOLO-LITESpiking-YOLODC-SPP-YOLOSpeechYOLOComplexer-YOLOSlimYOLOv3REQ-YOLOYOLO NanoxYOLOIFQ-Tinier-YOLODG-YOLOPoly-YOLOE-YOLOPP-YOLO

一、概述

我对yolo系列好感较高,虽不及其他系列的精度,速度,但是他现在已经精度与速度之中做了trade off ,侧端也友好。本文引自我爱计算机视觉,后续我将对这些算法消融对比,关注公众号(原文底部)敬请期待。

YOLO目标检测算法诞生于2015年6月,从出生的那一天起就是“高精度、高效率、高实用性”目标检测算法的代名词。

在原作者Joseph Redmon博士手中YOLO经历了三代到YOLOv3,今年初Joseph Redmon宣告退出计算机视觉研究界后,YOLOv4、YOLOv5相继而出,且不论谁是正统,这YOLO算法家族在创始人拂袖而出后依然热闹非凡。

本文带领大家细数在此名门之中自带“YOLO”的算法,总计 23 项工作,它们有的使YOLO更快,有的使YOLO更精准,有的扩展到了3D点云、水下目标检测、有的则在FPGA、CPU、树莓派上大显身手,甚至还有的进入了语音处理识别领域。

而几乎所有YOLO系算法都力图保持高精度、高效率、高实用性,这也许就是工业界偏爱YOLO的理由吧!

二、Yolo系列全家桶

YOLOv1 开山鼻祖之作

You Only Look Once: Unified, Real-Time Object Detection

作者:Joseph Redmon, Santosh Divvala, Ross Girshick, Ali Farhadi

单位:华盛顿大学;Allen Institute for AI;FAIR

论文:https://arxiv.org/abs/1506.02640

引用 | 10222

主页:https://pjreddie.com/darknet/yolo/

时间:2015年6月8日

标准版本的YOLO在Titan X 的 GPU 上能达到 45 FPS。更快的 Fast YOLO 检测速度可以达到 155 FPS。

![图片[4]-【你只需看一次】YOLO 全系列目标检测算法-卡咪卡咪哈-一个博客](https://pic4.zhimg.com/80/v2-435fd6bd4eb9eede8ea99133d0764a0f_720w.webp)

YOLOv2

YOLO9000: Better, Faster, Stronger

作者:Joseph Redmon, Ali Farhadi

单位:华盛顿大学;Allen Institute for AI

论文: https://arxiv.org/abs/1612.08242

引用 | 5168

主页:https://pjreddie.com/darknet/yolo/

时间:2016年12月25日

在 YOLO 基础上,保持原有速度的同时提升精度得到YOLOv2,让预测变得更准确(Better),更快速(Faster)。

通过联合训练策略,可实现9000多种物体的实时检测,总体mAP值为19.7。

![图片[5]-【你只需看一次】YOLO 全系列目标检测算法-卡咪卡咪哈-一个博客](https://pic1.zhimg.com/80/v2-0c03ca30d965746482a8e7453a0c01b8_720w.webp)

YOLOv3

YOLOv3: An Incremental Improvement

作者:Joseph Redmon, Ali Farhadi

单位:华盛顿大学

论文:https://arxiv.org/abs/1804.02767

引用 | 3363

主页:https://pjreddie.com/darknet/yolo/

Star | 18.3K

时间:2018年4月8日

在320×320 YOLOv3运行22.2ms,28.2 mAP,像SSD一样准确,但速度快三倍。在Titan X上,它在51 ms内实现了57.9的AP50,与RetinaNet在198 ms内的57.5 AP50相当,性能相似但速度快3.8倍。

![图片[6]-【你只需看一次】YOLO 全系列目标检测算法-卡咪卡咪哈-一个博客](https://pic3.zhimg.com/80/v2-e151de983c4af3e00811c2f634e50a4e_720w.webp)

YOLOv4 目标检测tricks集大成者

YOLOv4: Optimal Speed and Accuracy of Object Detection

作者:Alexey Bochkovskiy;Chien-Yao Wang;Hong-Yuan Mark Liao

单位:(中国台湾)中央研究院

论文:https://arxiv.org/pdf/2004.10934v1.pdf

引用 | 17

代码:https://github.com/AlexeyAB/darknet

Star | 11.9K

时间:2020年4月24

解读:YOLOv4来了!COCO 43.5 AP,65FPS!实现速度与精度的最优平衡

在MS COCO 数据集 实现 43.5% AP (65.7% AP50 ), 速度也更快了,在Tesla V100 GPU上 ∼65 FPS!

![图片[7]-【你只需看一次】YOLO 全系列目标检测算法-卡咪卡咪哈-一个博客](https://pic1.zhimg.com/80/v2-ccf6cb25cda34be5de621f1ac7306f38_720w.webp)

![图片[8]-【你只需看一次】YOLO 全系列目标检测算法-卡咪卡咪哈-一个博客](https://pic2.zhimg.com/80/v2-53bd99d2bebe2496021f257aa5d9c35d_720w.webp)

YOLOv5

2020年6月25日,Ultralytics发布了YOLOV5 的第一个正式版本,号称其性能与YOLO V4不相伯仲,同样也是现今最先进的目标检测技术,并在推理速度上是目前最强。

论文:无

代码:https://github.com/ultralytics/yolov5

Star | 3.5K

解读:一文读懂YOLOv5 与 YOLOv4

![图片[9]-【你只需看一次】YOLO 全系列目标检测算法-卡咪卡咪哈-一个博客](https://pic2.zhimg.com/80/v2-7ae47c2c08cc9eaa721f72058079fbdd_720w.webp)

![图片[10]-【你只需看一次】YOLO 全系列目标检测算法-卡咪卡咪哈-一个博客](https://pic4.zhimg.com/80/v2-b4e143d51ffdaf37d9b0d484ebb47457_720w.webp)

![图片[11]-【你只需看一次】YOLO 全系列目标检测算法-卡咪卡咪哈-一个博客](https://pic2.zhimg.com/80/v2-e9d23a6554ad70166bc6f32afb50c8dd_720w.webp)

Fast YOLO

Fast YOLO: A Fast You Only Look Once System for Real-time Embedded Object Detection in Video

作者:Mohammad Javad Shafiee, Brendan Chywl, Francis Li, Alexander Wong

单位:滑铁卢大学

论文:https://arxiv.org/abs/1709.05943

引用 | 53

时间:2017年9月18日

![图片[12]-【你只需看一次】YOLO 全系列目标检测算法-卡咪卡咪哈-一个博客](https://pic3.zhimg.com/80/v2-a87469d59f883056dfea1ccf4f1017d2_720w.webp)

![图片[13]-【你只需看一次】YOLO 全系列目标检测算法-卡咪卡咪哈-一个博客](https://pic2.zhimg.com/80/v2-ece3fe05c8d0f36d0e94810c11e011e1_720w.webp)

Complex-YOLO

Complex-YOLO: An Euler-Region-Proposal for Real-time 3D Object Detection on Point Clouds

作者:Martin Simon, Stefan Milz, Karl Amende, Horst-Michael Gross

单位:伊尔梅瑙工业大学

论文:https://arxiv.org/abs/1803.06199

引用 | 65

代码:https://github.com/ghimiredhikura/Complex-YOLOv3(非官方)

Star | 95(非官方)

代码:https://github.com/maudzung/Complex-YOLOv4-Pytorch(基于v4)

Star | 442(基于v4)

时间:2018年3月16日

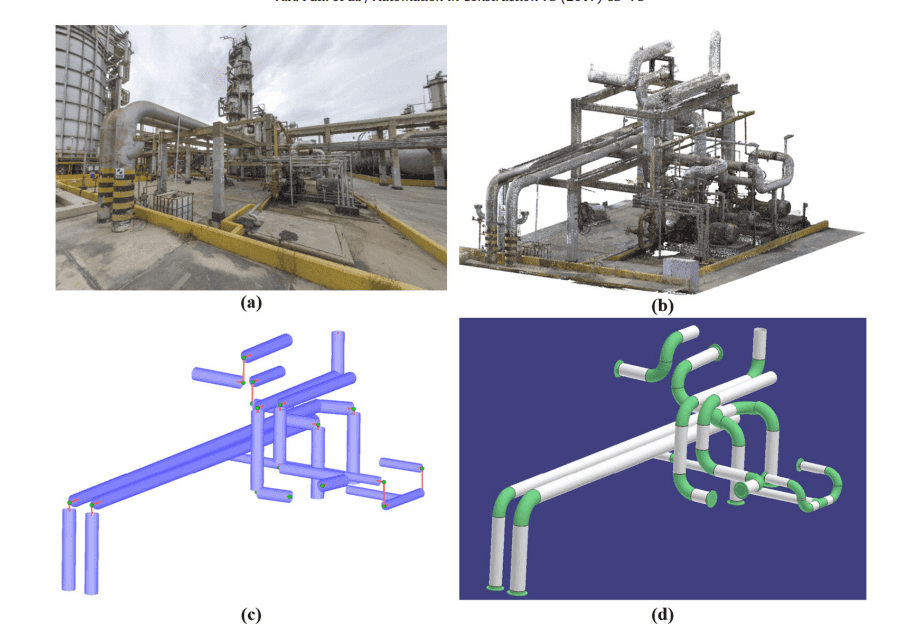

基于YOLOv2的一个变种,用于点云3D目标检测。

MV-YOLO

MV-YOLO: Motion Vector-aided Tracking by Semantic Object Detection

作者:Saeed Ranjbar Alvar, Ivan V. Bajić

单位:西蒙弗雷泽大学

论文:https://arxiv.org/abs/1805.00107

引用 | 10

时间:2018年4月30日

一种结合压缩视频中的运动信息和YOLO目标检测的目标跟踪算法。

YOLO3D

YOLO3D: End-to-end real-time 3D Oriented Object Bounding Box Detection from LiDAR Point Cloud

作者:Waleed Ali, Sherif Abdelkarim, Mohamed Zahran, Mahmoud Zidan, Ahmad El Sallab

单位:Valeo AI Research, Egypt

论文:https://arxiv.org/abs/1808.02350

引用 | 26

备注:ECCV 2018 Workshop

时间:2018年8月7日

YOLO-6D

这个3D bounding box可以表示一个物体的姿态。那什么是物体的姿态?实际上就是物体在3D空间中的空间位置xyz,以及物体绕x轴,y轴和z轴旋转的角度。换言之,只要知道了物体在3D空间中的这六个自由度,就可以唯一确定物体的姿态。

知道物体的姿态是很重要的。对于人来说,如果我们想要抓取一个物体,那么我们必须知道物体在3D空间中的空间位置xyz,但这个还不够,我们还要知道这个物体的旋转状态。知道了这些我们就可以愉快地抓取了。对于机器人而言也是一样,机械手的抓取动作也是需要物体的姿态的。因此研究物体的姿态有很重要的用途。

Real-Time Seamless Single Shot 6D Object Pose Prediction这篇文章提出了一种使用一张2D图片来预测物体6D姿态的方法。但是,并不是直接预测这个6D姿态,而是通过先预测3D bounding box在2D图像上的投影的1个中心点和8个角点,然后再由这9个点通过PNP算法计算得到6D姿态。我们这里不管怎么由PNP算法得到物体的6D姿态,而只关心怎么预测一个物体的3D bounding box在2D图像上的投影,即9个点的预测。

YOLO-LITE

YOLO-LITE: A Real-Time Object Detection Algorithm Optimized for Non-GPU Computers

作者:Jonathan Pedoeem, Rachel Huang

单位:佐治亚理工学院等

论文:https://arxiv.org/abs/1811.05588

引用 | 73

代码:https://reu2018dl.github.io/

Star | 336

时间:2018年11月14日

YOLO-LITE 是 YOLOv2-tiny 的Web实现,在 MS COCO 2014 和 PASCAL VOC 2007 + 2012 数据集上训练。在 Dell XPS 13 机器上可达到 21 FPS ,VOC 数据集上达到33.57 mAP。

Spiking-YOLO

Spiking-YOLO: Spiking Neural Network for Energy-Efficient Object Detection

作者:Seijoon Kim, Seongsik Park, Byunggook Na, Sungroh Yoon

单位:首尔大学

论文:https://arxiv.org/abs/1903.06530

引用 | 3

备注:AAAI 2020

解读:Spiking-YOLO : 前沿!脉冲神经网络在目标检测的首次尝试

时间:2019年3月12日

该文第一次将脉冲神经网络用于目标检测,虽然精度不高,但相比Tiny_YOLO 耗能更少。(研究意义大于实际应用意义)

DC-SPP-YOLO

DC-SPP-YOLO: Dense Connection and Spatial Pyramid Pooling Based YOLO for Object Detection

作者:Zhanchao Huang, Jianlin Wang

单位:北京化工大学

论文:https://arxiv.org/abs/1903.08589

引用 | 8

时间:2019年3月20日

该作提出一种DC-SPP-YOLO(基于YOLO的密集连接和空间金字塔池化技术)的方法来改善YOLOv2的目标检测精度。

SpeechYOLO

SpeechYOLO: Detection and Localization of Speech Objects

作者:Yael Segal, Tzeviya Sylvia Fuchs, Joseph Keshet

单位:巴伊兰大学

论文:https://arxiv.org/abs/1904.07704

引用 | 2

时间:2019年4月14日

YOLO算法启发的语音处理识别算法。

SpeechYOLO的目标是在输入信号中定位语句的边界,并对其进行正确分类。受YOLO算法在图像中进行目标检测的启发所提出的方法。

Complexer-YOLO

Complexer-YOLO: Real-Time 3D Object Detection and Tracking on Semantic Point Clouds

作者:Martin Simon, Karl Amende, Andrea Kraus, Jens Honer, Timo Sämann, Hauke Kaulbersch, Stefan Milz, Horst Michael Gross

单位:伊尔梅瑙工业大学等

论文:https://arxiv.org/abs/1904.07537

引用 | 24

时间:2019年4月16日

Complex-YOLO的改进版,用于实时点云3D目标检测与跟踪,推断速度加速20%,训练时间减少50%。

SlimYOLOv3

SlimYOLOv3: Narrower, Faster and Better for UAV Real-Time Applications

作者:Pengyi Zhang, Yunxin Zhong, Xiaoqiong Li

单位:北理工

论文:https://arxiv.org/abs/1907.11093

引用 | 18

解读:SlimYOLOv3:更窄、更快、更好的无人机目标检测算法

代码:https://github.com/PengyiZhang/SlimYOLOv3

Star | 953

时间:2019年7月15日

该文对YOLOv3的卷积层通道剪枝,大幅削减了模型的计算量(~90.8% decrease of FLOPs)和参数量( ~92.0% decline of parameter size),剪枝后的模型在基本保持原模型的检测精度同时,运行速度约为原来的两倍。

REQ-YOLO

REQ-YOLO: A Resource-Aware, Efficient Quantization Framework for Object Detection on FPGAs

作者:Caiwen Ding, Shuo Wang, Ning Liu, Kaidi Xu, Yanzhi Wang, Yun Liang

单位:北大;东北大学;鹏城实验室

论文:https://arxiv.org/abs/1909.13396

引用 | 14

时间:2019年9月29日

Tiny-YOLO的 FPGA 实现,REQ-YOLO速度可高达200~300 FPS!

YOLO Nano

YOLO Nano: a Highly Compact You Only Look Once Convolutional Neural Network for Object Detection

作者:Alexander Wong, Mahmoud Famuori, Mohammad Javad Shafiee, Francis Li, Brendan Chwyl, Jonathan Chung

单位:滑铁卢大学;DarwinAI Corp

论文:https://arxiv.org/abs/1910.01271

引用 | 6

时间:2019年10月3日

YOLO Nano 比 Tiny YOLOv2 和 Tiny YOLOv3更小,更快,mAP更高!模型仅4.0MB。在 NVIDIA Jetson Xavier上速度竟高达26.9~48.2 FPS!

PP-YOLO

PP-YOLO: An Effective and Efficient Implementation of Object Detector

作者:Xiang Long, Kaipeng Deng, Guanzhong Wang, Yang Zhang, Qingqing Dang, Yuan Gao, Hui Shen, Jianguo Ren, Shumin Han, Errui Ding, Shilei Wen

单位:百度

论文:https://arxiv.org/abs/2007.12099

解读:https://zhuanlan.zhihu.com/p/163565906

代码:https://github.com/PaddlePaddle/PaddleDetection

时间:2020年7月23日

PP-YOLO由在YOLOv3上添加众多tricks“组合式创新”得来,从下图前两列中可看到其使用的技术:

PP-YOLO在精度和效率之间取得更好的平衡,在COCO数据集上达到45.2% mAP,并且速度72.9 FPS!,超越YOLOv4和谷歌EfficientDet,是更加实用的目标检测算法。

引自我爱计算机视觉,后续将对上述yolo算法实践或优化,敬请关注博主,以及公众号:

Yolo系列确实优化改进特别多,可能正是由于热爱吧!

暂无评论内容