选自arxiv

机器之心编译

编辑:rome rome

Stable Diffusion 学会了「偷天换日」的本领。

任何一个创作过程,都是始于「模仿」、终于「创造」。对于 AI 来说,这一学习过程也是相同的。

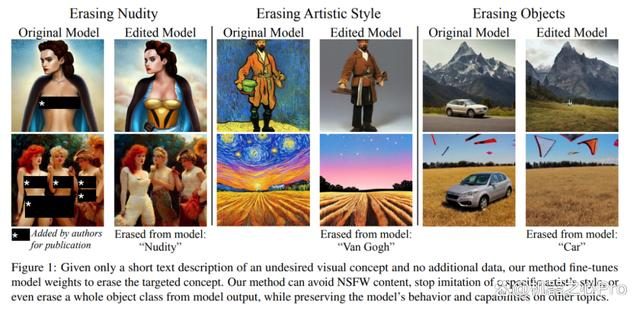

近期,开源版本的 Stable Diffusion 文本到图像的扩散模型,使图像生成技术得到极为广泛的应用,但是如何规避色情或风格侵权是需要解决的问题,作者提出 Erased Stable Diffusion(ESD)方法,有效的解决了前面的问题。

文本到图像生成模型备受关注,其具备优秀的图像生成质量和看似无限的生成潜力。诸如此类的生成模型都是基于大规模的互联网数据集进行训练的,这使它们能够学习很广泛的概念。然而,模型生成的一些概念是不受欢迎的,比如受版权保护的内容和色情内容。

如何尽量避免模型输出这些内容呢?在最近的一篇论文中,来自美国东北大学、麻省理工学院的作者提出了一种在预训练之后有选择地从文本条件模型的权重中删除单个概念的方法。

论文链接:https://arxiv.org/pdf/2303.07345v1.pdf

此前的方法侧重于数据集过滤、post-generation 过滤或推理指导,而本文提出的方法不需要重新训练,这对于大型模型来说是不可思议的。基于推理的方法可以审查或有效引导模型输出的方式以避免生成不需要的概念。相比之下,本文的方法直接从模型的参数中将概念移除,从而可以安全地分配其权重。

图像生成中的安全问题

Stable Diffusion 文本到图像扩散模型的开源,让图像生成技术得到了极为广泛的应用,但也带来了一些问题。

为了限制不安全图像的生成,第一个 Stable Diffusion 版本绑定了 NSFW 滤波器,以便在滤波器被触发时审查图像,但由于代码和模型权重都是公开可用的,因此滤波器很容易被禁用。

为了防止敏感内容的生成,随后的 Stable Diffusion 2.0 模型对过滤的数据进行训练,以删除明显有问题的图像,实验是在 50 亿张图像的 LAION 数据集上进行的,消耗了 15 万个 GPU 时。

如此一来,整个过程的成本之高,使得在数据发生变化与涌现能力之间建立因果关系这件事极具挑战性。有些研究人员反映,从训练数据中删除明显问题图像和其他主题可能会对输出质量产生负面影响。

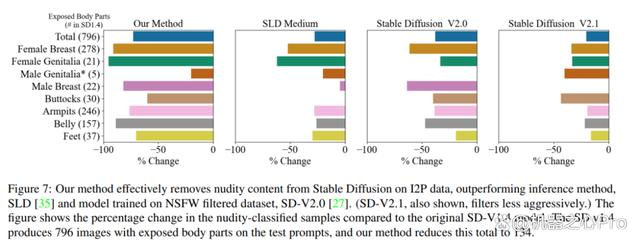

尽管作者们付出了一系列努力,涉及色情的内容在模型的输出中仍然很普遍:当作者使用 Inappropriate Image Prompts (I2P) 基准测试的 4703 个 prompt 来评估图像的生成结果时,他们发现当前流行的 SD1.4 模型生成了 796 张暴露的身体部位的图片,而新的受训练集限制的 SD2.0 模型产生 417 张类似图片。

另一个问题是,文本到图像模型所模仿的作品可能是受版权保护的。AI 生成的艺术作品不仅在质量上与人类生成的艺术相媲美,而且还可以忠实地复制真实艺术家的艺术风格。Stable Diffusion 和其他大型文本到图像合成系统的用户发现,诸如「art in the style of [artist]」之类的 prompt 可以模仿特定艺术家的风格,从而有可能产生侵权的作品。此前,也正是因为多位艺术家的担忧,导致了一场针对 Stable Diffusion 制作主体的法律诉讼 —— 艺术家指控 Stable Diffusion 侵犯了他们的作品。为了保护艺术家,最近的一些工作尝试于在线发布艺术作品之前对艺术作品应用对抗干扰,以防止模型模仿它。然而,这种方法并不能从预训练模型中删除模型本已学习到的艺术风格。

因此,为了解决安全和版权侵犯的问题,本文的作者们提出了一种从文本到图像模型中「擦除概念」的方法,即 Erased Stable Diffusion(ESD),可以通过微调模型参数来实现擦除,而不需要额外的训练数据。

相比于训练集审查方法,本文提出的方法速度更快,并且不需要从头开始训练整个系统。此外,ESD 可用于目前已有的模型,无需修改输入图像。相比于 post-generation 过滤或简单的黑名单方法,「擦除」是不容易被绕过的,即使用户可以访问参数。

方法

ESD 方法的目标是使用自身的知识从文本到图像扩散模型中擦除概念,而不需要额外的数据。因此,ESD 选择微调预训练模型而不是从头开始训练模型。本文方法专注于 Stable Diffusion(SD),一个由三个子网络组成的 LDM,包括一个文本编码器 T、一个扩散模型 (U-Net)θ 和一个解码器模型 D。

ESD 通过编辑预训练的扩散 U-Net 模型的权重 θ 去除特定的风格或概念。ESD 是受到了无分类器指导方法和基于分数的合成等工作的启发。具体来说,使用无分类器指导的原则来训练扩散模型,将模型的分数从想要消除的特定概念 c 中擦除,例如「Van Gogh」这种词语。利用预训练模型对概念的认知,同时让其学习将微调输出的分布的质量从该概念中移除。

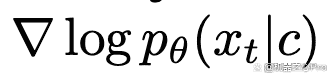

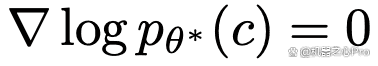

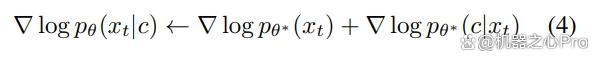

扩散模型的 score-based 的公式中,目标是学习条件模型的分数 。使用贝叶斯规则和

。使用贝叶斯规则和

。使用贝叶斯规则和

。使用贝叶斯规则和

可得出:

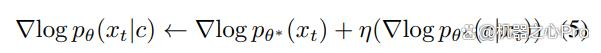

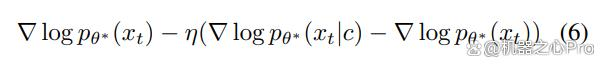

这可以解释为具有来自分类器 pθ(c|xt) 的梯度的无条件 score。为了控制条件性的影响,作者为分类器梯度引入了一个指导因子 η

作者希望通过反转的行为来否定概念 c,因此使用负面版本的指导来训练 θ。此外,受到无分类器引导的启发,作者将等式 5 的 RHS 从分类器转换为条件扩散。

基于 Tweedie 公式以及重新参数化技巧,对数概率 score 的梯度可以表示为通过时变参数缩放的 score 函数。修改后的 score 函数移动数据分布以使对数概率 score 最大化。

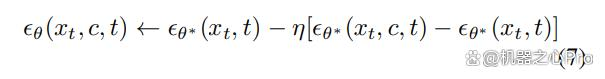

方程 7 中的目标函数通对参数 θ 进行微调,使得 θ(xt,c,t) 来模拟负向引导噪声。因此,在微调后,编辑过的模型的条件预测会远离被擦除的概念。

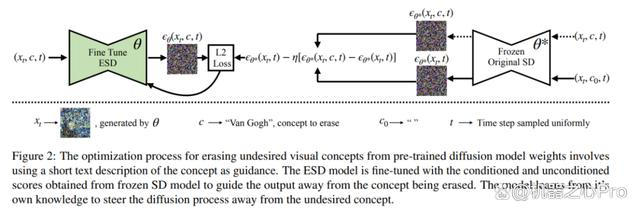

下图展示了训练过程。利用模型对概念的知识合成训练样本,从而消除了数据收集的需要。训练使用几个扩散模型实例,其中一组参数被冻结( ),而另一组参数(θ)被训练以擦除概念。使用 θ 对条件 c 下的部分去噪图像 xt 进行采样,然后对冻结模型进行两次推理以预测噪声,一次在条件 c 下,另一次是没有任何条件。最后,线性组合这两个预测结果以抵消与概念相关的预测噪声,并将新模型朝着新目标调整。

实验

艺术风格去除

为了分析对当代实践艺术家中的艺术模仿情况,作者选取了 5 位现代艺术家和艺术作品进行考察,分别是:Kelly McKernan、Thomas Kinkade、Tyler Edlin、Kilian Eng 以及「Ajin:Demi-Human」系列作品。据报道,这些作者或作品都曾被 Stable Diffusion 模型模仿。虽然作者没有观察到该模型直接复制某些特定的原创艺术作品,但不可否认的是,该模型必然捕捉到了这些艺术风格。

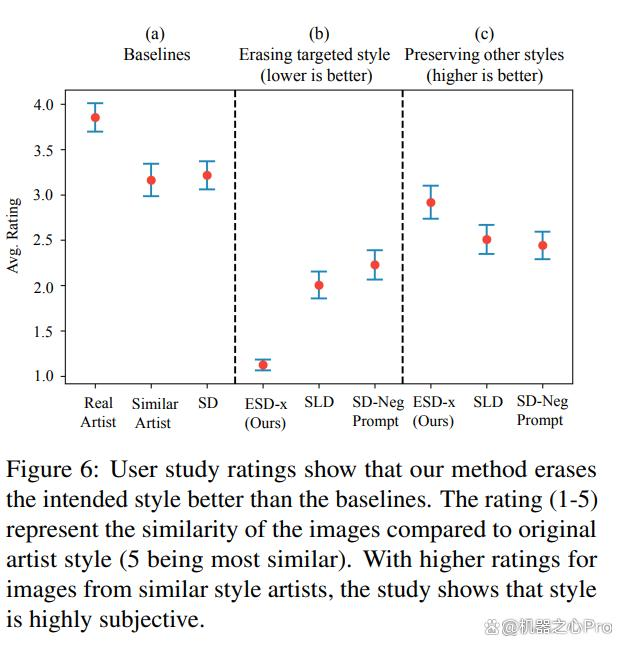

图 5 展示了相关定性结果,作者还进行了用户研究(图 6)以衡量人类对艺术风格去除效果的感知。最终的实验结果验证了该观察结果,即模型已经去除了特定艺术家的风格,同时保留了 prompt 内容和结构(图 5),并且对其它艺术风格的干扰最小。

显式内容删除

在图 7 中,与 Stable Diffusion v1.4 相比,裸体分类样本的百分比变化。作者通过使用推理方法(SLD)和过滤再训练方法(SD V2.0)研究了 ESD 的有效性。对于所有模型,使用的都是由 I2P prompt 生成 4703 张图像。他们使用 Nudenet 检测器将图像分类为各种裸体类别。结论是,在弱擦除比例 η=1 时,在所有类别中,ESD 方法在擦除裸体方面效果更显著。

物体去除

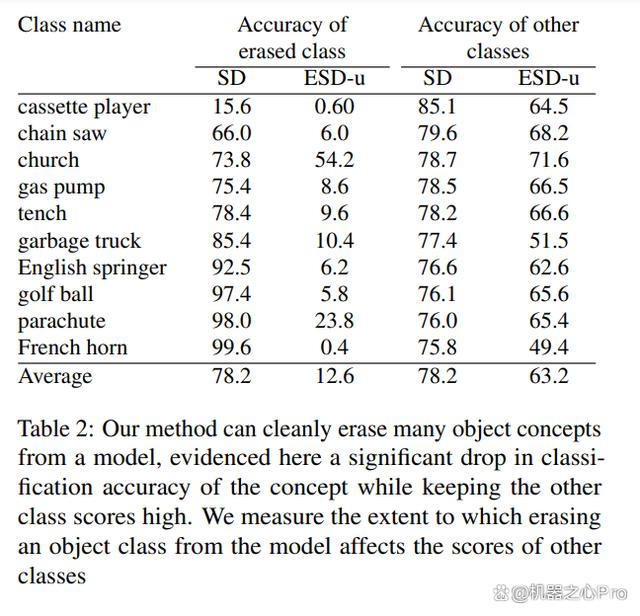

表 2 中展示了原始 Stable Diffusion 模型和 ESD-u 模型在训练过程中擦除目标类时分类准确性的对比结果,同时展示了在生成剩余的九个类时的分类准确性。结果表明,ESD 能够在大多数情况下有效地去除目标类,尽管有一些类别(比如教堂)比较难去除。但未被去除的类别的分类准确性仍然很高,即使某些情况下会有一些干扰,例如,去除「法国圆号」会对其他类别造成明显的失真。作者在补充材料中提供了物体去除后的视觉效果图像。

更多研究细节,可参考原论文。

举报/反馈

THE END

暂无评论内容