大型语言模型成为了人工智能领域的热门技术之一,其中最具代表性的就是ChatGPT,它不仅在生成自然语言上取得了重大突破,也在众多领域得到了广泛的应用。那么,ChatGPT的原理是什么,如何利用大型语言模型生成自然语言呢?

一、ChatGPT的原理

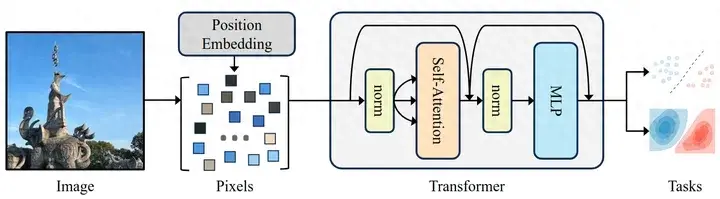

ChatGPT是基于Transformer模型的大型语言模型,它由OpenAI团队开发,通过对大量文本数据的预训练来学习语言模式和语言规律,从而实现了生成自然语言的能力。ChatGPT的原理可以分为两个步骤:预训练和微调。

1.预训练

在预训练阶段,ChatGPT使用海量的语料库进行训练,例如Wikipedia、BookCorpus等,通过自监督学习方法来学习语言模式。具体来说,ChatGPT使用了一个叫作Masked Language Modeling (MLM)的技术,将文本中的一些单词随机替换成一个特殊符号,然后让模型预测这些被替换的单词。这种训练方式可以让模型学习到单词之间的关系和上下文信息,从而提高模型的生成自然语言的能力。

2.微调

在预训练完成后,ChatGPT可以在特定的任务上进行微调,例如对话生成、问答、文本摘要等。在微调阶段,模型会在任务相关的语料库上继续进行训练,以适应特定的应用场景。与预训练相比,微调需要的数据量相对较少,但可以大大提高模型在特定任务上的准确性和效率。

二、利用大型语言模型生成自然语言

ChatGPT的生成自然语言能力是基于大型语言模型的,其主要思想是将给定的前缀(例如一个单词、一个短语或一句话)作为输入,然后通过模型生成一段合理的文本作为输出。生成过程是通过贪心搜索或Beam Search等算法实现的。

以对话生成为例,当用户输入一段对话前缀时,ChatGPT将前缀作为输入,然后根据前缀生成一段响应。具体来说,ChatGPT将前缀转化为向量表示,并将该向量输入到模型中。模型会根据前缀的上下文信息生成一段合理的响应,并将响应作为下一轮对话的输入。这个过程将不断循环,直到达到预定的停止条件,例如生成的文本长度达到一定值或者出现特定的结束标志。

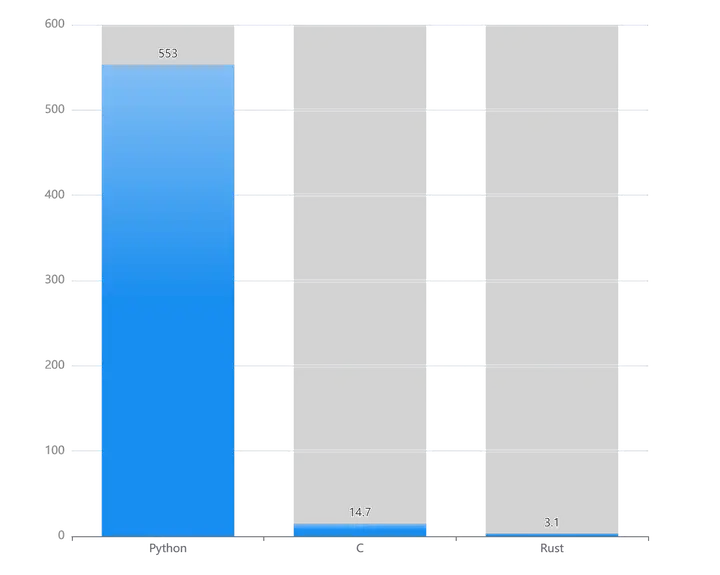

在生成自然语言的过程中,大型语言模型需要学习并记住语言的规则、结构和语义等方面的知识,并根据已有的文本数据进行预测。在这个过程中,模型需要处理的数据规模非常庞大,因此需要使用分布式计算和深度学习框架等先进技术。

同时,大型语言模型还需要解决一些困难的问题,例如如何避免生成不通顺、不合理或者不符合语法规则的文本。为了解决这些问题,研究人员提出了一系列优化技术,例如基于多任务学习的方法、基于对抗训练的方法以及基于人类纠错的方法等。

总的来说,大型语言模型的生成自然语言能力是人工智能领域中的一个重要研究方向,其在对话生成、文本摘要、机器翻译等领域都具有广泛的应用前景。

ChatGPT的训练和运行需要消耗大量的计算资源,同时对网络的稳定性和速度也有较高的要求。因此,利用网络工具如maxproxy,可以为ChatGPT提供更好的网络环境,提高其在各个领域的应用效果和稳定性。

maxproxy是一款高性能的代理服务器软件,可以提供负载均衡、流量控制、安全加密等功能。通过maxproxy,用户可以将网络请求分发到多个服务器上,以提高处理效率和吞吐量。同时,maxproxy还可以实现流量控制和安全加密等功能,保护数据的安全性和隐私性。

在ChatGPT的应用中,maxproxy可以作为一种网络加速器,优化模型训练和推理过程中的网络流量,提高模型的运行效率和响应速度。同时,maxproxy还可以对网络流量进行分流和负载均衡,保证模型在高并发情况下的稳定性和可靠性。此外,maxproxy还可以提供网络安全防护,保护数据的安全性和隐私性。

综上所述,利用maxproxy等网络工具可以为ChatGPT提供更好的网络环境,提高其在各个领域的应用效果和稳定性。在未来,随着人工智能技术的不断发展和应用,ChatGPT将会成为人工智能领

暂无评论内容