近日,在火爆全球的AI聊天机器人ChatGPT上线四个月后,OpenAI又发布了ChatGPT-4。从OpenAI的官网可以了解到,与上一个版本相比,GPT-4 拥有了更广的知识面和更强的解决问题能力,在创意、视觉输入和长内容上都有更好的表现。GPT-4是一个超大的多模态模型,实现了从文本理解到图像理解的飞跃式提升:包括强大的识图能力;文字输入限制从不足万字提升至 2.5 万字;回答准确性显著提高;输出层面能够生成歌词、创意文本,实现风格的多样性变化。

OpenAI的创始人Sam Altman甚至介绍:这是我们迄今为止功能最强大的模型!

大规模预训练语言模型的定义

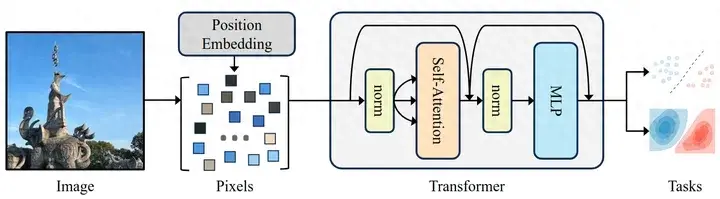

大规模预训练语言模型(Large Language Model,LLM)是指一种深度学习模型,它可以学习大量的语言知识,并能够生成自然流畅的语言文本。这些模型通常基于Transformer深度学习模型,使用海量语料进行预训练,然后通过微调等技术进行进一步任务适配。目前,顶尖的大模型参数量过千亿,已经被观察到有能力涌现的情况——即不需要微调,就可以快速在上下文中学习,完成多类任务。

ChatGPT正是基于Transformer模型的大规模预训练语言模型,通过在人工标注和反馈的大规模数据上进行学习,使模型能够更好地理解人类的问题,通过自然流畅的语言文本,给出相应的回复。

大模型的背后训练语料

预训练语料的选择对于模型的最终质感有着重要的影响。当前,训练LLM所需的语料库通常来自于互联网上公开可用的数据文本、网页文本和源代码文本等。如Wikipedia、Common Crawl等。虽然这些语料库规模庞大,但其中可能会存在重复、过时、错误的信息,可能会对LLM的训练和应用产生负面影响。

因此,语料的去重和提纯至关重要。为了确保模型训练的质量和效果,在构建大型语言模型的语料库时,开发者往往需要经过多个步骤的处理才能得到可用的语料。

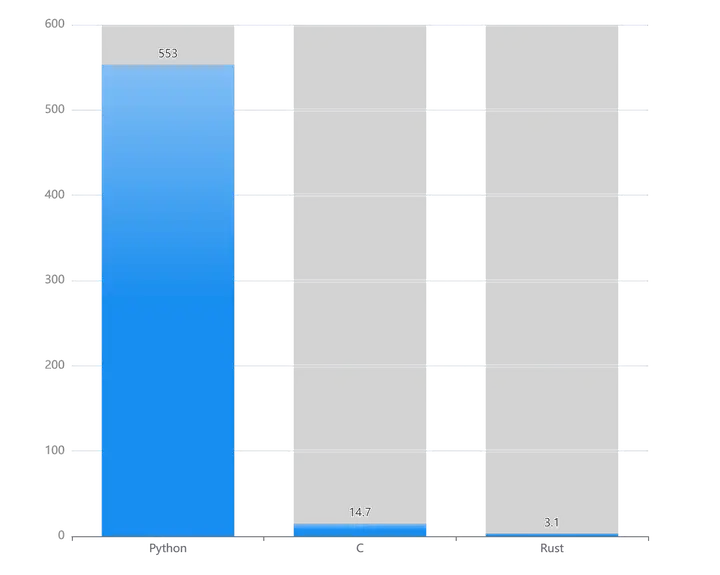

据统计,从GPT进化到GPT-3,预训练数据量从5GB增加到45TB。在训练GPT 3.5的过程中,为了保证语料的质量和多样性,OpenAI使用了多种技术和方法来清理和筛选语料。

首先,OpenAI通过爬虫程序定期从互联网上收集文本数据,并使用机器学习技术自动清洗和处理这些数据。其次,OpenAI针对不同的应用场景选择不同类型的语料,以确保语料库的多样性和覆盖面。此外,除了从互联网上收集语料和使用特殊的数据集,OpenAI还使用了对抗式训练技术来增强模型的稳健性和鲁棒性。

大语言模型的终身学习

随着人们对大语言模型的依赖越来越深,大模型的终身学习问题变得越来越重要。终身学习也叫做增量学习,指的是快速为大语言模型添加新的知识的过程。

通常来说,大语言模型的训练都是以数月或者数周为周期进行,由于使用的语料数量非常大,提前清洗的工序也需要占用一定的时间,每个模型成型的时候,最近几个月的数据都不会被训练进去。例如,初代chatGPT并不知道我国的疫情管控措施放开了。

在训练过程中,新的数据需要与旧的数据进行交互,但是由于模型已经被训练得非常复杂,新数据的引入可能会对已有的知识造成干扰,从而导致模型的性能下降。

此外,增量学习还需要考虑如何避免过拟合、如何有效利用新数据等问题。为大语言模型提供新知识的方法,通常是收集到新的语料,并且高效地调整模型中极少量的参数,在不引起副作用的情况下让模型学到新的知识。这类微调方法目前已经有几种效果不错的尝试,包括loRA、A-gen等。但是新语料的快速清洗和发布则没有看到成型的解决方案。

标贝科技致力于为预训练大语言模型提供终身学习语料

如何为大规模预训练语言模型提供最新的、多样化高质量语料,并将其清洗、筛选、评估成为行业面临的一大挑战。作为行业领先的AI数据解决方案提供商,标贝科技做好数据服务技术创新的同时,也始终在积极探索如何满足大规模预训练语言模型的需求,有效提高语料库的质量和多样性,增加数据使用的价值。

首先,我们可以引入学习价值评估的模型,对语料进行自动化的筛选和评估。这些模型可以基于非监督学习的方法,从每天新爬取的语料库中挖掘出高质量、有用的语料,并对其进行标注和评分。例如,使用主题模型和情感分析技术来评估语料的相关性和情感色彩,从而确定哪些语料最适合用于预训练模型的更新。此外,还可以引入谣言检测等机制,每天将检测到的新的谣言从历史数据中删除,以确保语料库的准确性和可靠性。

其次,利用最新的自然语言处理技术和机器学习技术来获取更新的语料。例如,使用最新的爬虫技术和自动化工具来从互联网上获取最新的新闻和热门表达方式,并使用自然语言处理技术来将其清洗和转换成适合于预训练模型的格式。此外,还可以利用机器学习技术来自动标注和分类语料,从而提高语料库的多样性和覆盖范围。

最后,将最新的语料库与其他数据集进行整合,以获得更全面和多样化的语料。例如,将维基百科、Common Crawl等公共数据集与自己的语料库进行整合,并使用聚类分析和文本挖掘技术来发现新的语料和知识。此外,还可以利用人工智能技术和专业知识来对语料库进行领域划分和分类,以满足不同行业和领域的需求。

总之,ChatGPT的成功,也代表着AI应用从以专用小模型训练阶段为主跨越到以通用大模型预训练为主阶段,面对上百亿、万亿规模的训练参数,对算力、数据、算法均提出了更高的要求。标贝科技作为AI数据服务领域代表品牌,始终致力于以先进的技术和数据服务满足前沿部署需求。未来,我们也将持续布局,加码研发投入,携手国内外上下游合作伙伴,共同为预训练大语言模型提供学习价值更高的语料,助力AI产业腾飞。

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。

暂无评论内容