来源: AINLPer

微信公众号(每日更新…)

编辑: ShuYini

校稿: ShuYini

时间: 2020-08-08引言: 给大家分享一下中文自然语言处理可能用到的数据集,感兴趣的小伙伴可以收藏,以备不时之需。具体主要包括:中文常用词停用词数据集、汉语拆字词表、中文词表、人名语料库、中文缩写数据库、中文专业领域词库、中文敏感词库、维基百科词条(104万)、新闻语料json版(250万篇)、百科类问答json版(150万)、社区问答json版(410万)、翻译语料(520万对)等。

以下数据打包获取方式:关注AINLPer 微信公众号(每日更新…)回复:YL001

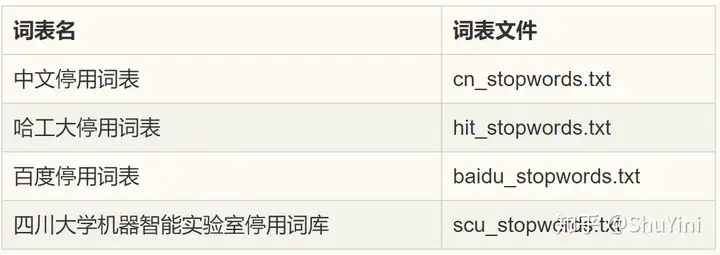

中文常用词停用词数据集

该数据集主要包括中文停用词表、哈工大停用词表、百度停用词表、四川大学机器智能实验室停用词库四个部分。

汉语拆字词表

该词表主要用以提供字旁和部首查询的拆字字典数据库,有利于使用者去查难打汉字等用途。该数据集收录了17,803个不同汉字的拆法,分为繁体拆字表和简体字拆字表两个版本。拆字法有别于固有的笔顺字库。拆字尽量把每个字拆成两个以上的组成部件,而不是拆成手写字时所使用的笔画。

繁体eg:丳 串 丿

丵 业 丷 干

简体eg:丗 廿 丨 十 凵

丘 厂 工 厂 丅 一中文词表

本词表主要包括:同义词表、反义词表、否定词表。

同义词表eg:Aa01A04= 劳力 劳动力 工作者、Aa01A05= 匹夫 个人、Aa01A08= 每人 各人 每位、等等。

反义词表eg:前-后、冷-热、高-矮、进-退、等等。

否定词表eg:非、别、不、没、无、勿、等等。人名语料库

该语料库主要包括中文人名语料库【中文常见人名(数据量:120万)、中文古代人名(数据量:25万)、中文姓氏(数据量:1千)、中文称呼(数据量:5千))】、英文人名语料库【翻译人名(数据量:48万)】、日文人名语料库【日本人名(数据量:18万)】、中文成语词典(数据量:5万)。

中文成语词库、中文名字词库(古代名字词库、中文关系称呼词库、现代名字词库、中文名字性别词库、中文姓氏词库)中文缩写数据库

缩略语是一种跨语言的普遍现象,尤其是在汉语中。在大多数情况下,如果一个表达可以缩写,它的缩写会比它的完整形式使用的更多,因为人们倾向于以最简明的方式传达信息。对于各种语言处理任务,缩略语是提高性能的一个障碍,因为缩略语的文本形式不能表达有用的信息,除非它被扩展为完整的形式。本数据库主要是中文的简写,比如:影业是电影业的缩写、北大是北京大学的缩写、村委会是村民委员会、优种是优良的品种等。

史地: 历史/n 和/cc 地理/n

文委会: 文化/n 教育委员会/nt

营运: 营业/vn 运行/vn中文专业领域词库

该词库主要包括IT行业、财经、汽车、成语、地名、食物、法律、历史名人、医药、诗词等。

IT.txt、car.txt、chengyu.txt、diming.txt、food.txt、law.txt、lishimingren.txt、medical.txt、poem.txt、…中文敏感词库

该词库主要包括暴恐词库、反动词库、民生词库、敏感词词库、色情词库、贪腐词库。

暴恐词库.txt、反动词库.txt、民生词库.txt、敏感词库表统计.txt、色情词库.txt、贪腐词库.txt 等等维基百科词条(104万)

该数据具体包含104万个词条(1,043,224条; 原始文件大小1.6G,压缩文件519M;数据更新时间:2019.2.7),可以做为通用中文语料,做预训练的语料或构建词向量,也可以用于构建知识问答。

例子: {“id”: “53”, “url”: “https://zh.wikipedia.org/wiki?curid=53“, “title”: “经济学”, “text”: “经济学\n\n经济学是一门对产品和服务的生产、分配以及消费进行研究的社会科学。西方语言中的“经济学”一词源于古希腊的。\n\n经济学注重的是研究经济行为者在一个经济体系下的行为,以及他们彼此之间的互动。在现代,经济学的教材通常将这门领域的研究分为总体经济学和个体经济学。微观经济学检视一个社会里基本层次的行为,包括个体的行为者(例如个人、公司、买家或卖家)以及与市场的互动。而宏观经济学则分析整个经济体和其议题,包括失业、通货膨胀、经济成长、财政和货币政策等。…”}新闻语料json版(250万篇)

包含了250万篇新闻。新闻来源涵盖了6.3万个媒体,含标题、关键词、描述、正文。数据集划分:数据去重并分成三个部分。训练集:243万;验证集:7.7万;测试集,数万,不提供下载。可以做为【通用中文语料】,训练【词向量】或做为【预训练】的语料;也可以用于训练【标题生成】模型,或训练【关键词生成】模型(选关键词内容不同于标题的数据);亦可以通过新闻渠道区分出新闻的类型。

例子: {“news_id”: “610130831”, “keywords”: “导游,门票”,”title”: “故宫淡季门票40元 “黑导游”卖外地客140元”, “desc”: “近日有网友微博爆料称,故宫午门广场售票处出现“黑导游”,专门向外地游客出售高价门票。昨日,记者实地探访故宫,发现“黑导游”确实存在。窗口出售”, “source”: “新华网”, “time”: “03-22 12:00”, “content”: “近日有网友微博爆料称,故宫午门广场售票处出现“黑导游”,专门向外地游客出售高价门票。昨日,记者实地探访故宫,发现“黑导游”确实存在。窗口出售40元的门票,被“黑导游”加价出售,最高加到140元。故宫方面表示,请游客务必通过正规渠道购买门票,避免上当受骗遭受损失。目前单笔门票购买流程不过几秒钟,耐心排队购票也不会等待太长时间。….再反弹”的态势,打击黑导游需要游客配合,通过正规渠道购买门票。”}百科类问答json版(150万)

含有150万个预先过滤过的、高质量问题和答案,每个问题属于一个类别。总共有492个类别,其中频率达到或超过10次的类别有434个。数据集划分:数据去重并分成三个部分。训练集:142.5万;验证集:4.5万;测试集,数万,不提供下载。 可以做为通用中文语料,训练词向量或做为预训练的语料;也可以用于构建百科类问答;其中类别信息比较有用,可以用于做监督训练,从而构建更好句子表示的模型、句子相似性任务等。

{“qid”: “qid_2540946131115409959”, “category”: “生活知识”, “title”: “冬天进补好一些呢,还是夏天进步好啊? “, “desc”: “”, “answer”: “你好!\r\r当然是冬天进补好的了,夏天人体的胃处于收缩状态,不适宜大量的进补,所以我们有时候说:“夏天就要吃些清淡的,就是这个道理的。” \r\r二忌以药代食。重药物轻食物的做法是不科学的,许多食物也是好的滋补品。如多吃荠菜可治疗高血压;多吃萝卜可健胃消食,顺气宽胸;多吃山药能补脾胃。日常食用的胡桃、芝麻、花生、红枣、扁豆等也是进补的佳品。\r\r三忌越贵越好。每个人的身体状况不同,因此与之相适应的补品也是不同的。价格昂贵的补品如燕窝、人参之类并非对每个人都适合。每种进补品都有一定的对象和适应症,应以实用有效为滋补原则,缺啥补啥。”}社区问答json版(410万)

含有410万个预先过滤过的、高质量问题和回复。每个问题属于一个【话题】,总共有2.8万个各式话题,话题包罗万象。从1400万个原始问答中,筛选出至少获得3个点赞以上的的答案,代表了回复的内容比较不错或有趣,从而获得高质量的数据集。

除了对每个问题对应一个话题、问题的描述、一个或多个回复外,每个回复还带有点赞数、回复ID、回复者的标签。

数据集划分:数据去重并分成三个部分。训练集:412万;验证集:6.8万;测试集a:6.8万;测试集b,不提供下载。

用途介绍

1)构建百科类问答:输入一个问题,构建检索系统得到一个回复或生产一个回复;或根据相关关键词从,社区问答库中筛选出你相关的领域数据 2)训练话题预测模型:输入一个问题(和或描述),预测属于话题。 3)训练社区问答(cQA)系统:针对一问多答的场景,输入一个问题,找到最相关的问题,在这个基础上基于不同答案回复的质量、 问题与答案的相关性,找到最好的答案。 4)做为通用中文语料,做大模型预训练的语料或训练词向量。其中类别信息也比较有用,可以用于做监督训练,从而构建更好句子表示的模型、句子相似性任务等。 5)结合点赞数量这一额外信息,预测回复的受欢迎程度或训练答案评分系统。

例子: {“qid”: 65618973, “title”: “AlphaGo只会下围棋吗?阿法狗能写小说吗?”, “desc”: “那么现在会不会有智能机器人能从事文学创作?

如果有,能写出什么水平的作品?”, “topic”: “机器人”, “star”: 3, “content”: “AlphaGo只会下围棋,因为它的设计目的,架构,技术方案以及训练数据,都是围绕下围棋这个核心进行的。它在围棋领域的突破,证明了深度学习深度强化学习MCTS技术在围棋领域的有效性,并且取得了重大的PR效果。AlphaGo不会写小说,它是专用的,不会做跨出它领域的其它事情,比如语音识别,人脸识别,自动驾驶,写小说或者理解小说。如果要写小说,需要用到自然语言处理(NLP))中的自然语言生成技术,那是人工智能领域一个”, “answer_id”: 545576062, “answerer_tags”: “人工智能@游戏业”}翻译语料(520万对)

该语料包括中英文平行语料520万对。每一对包含一个英文和对应的中文。中文或英文,多数情况是一句带标点符号的完整的话。对于一个平行的中英文对,中文平均有36个字,英文平均有19个单词(单词如“she”) 数据集划分:数据去重并分成三个部分。训练集:516万;验证集:3.9万;测试集,数万,不提供下载。

用途介绍

可以用于训练中英文翻译系统,从中文翻译到英文,或从英文翻译到中文;由于有上百万的中文句子,可以只抽取中文的句子,做为通用中文语料,训练词向量或做为预训练的语料。英文任务也可以类似操作; 例子:{“english”: “In Italy, there is no real public pressure for a new, fairer tax system.”, “chinese”: “在意大利,公众不会真的向政府施压,要求实行新的、更公平的税收制度。”}Attention

更多自然语言处理相关知识,还请关注AINLPer公众号,极品干货即刻送达。

暂无评论内容