原标题:基于神经网络算法的TeamFree会议一体机降噪实战

在线会议、在线教育、直播等线上模式改变了办公、教育等行业的传统交互模式,成为时下新兴的刚需,原来小众领域的应用,正在向更广泛的领域渗透。C端应用场景逐渐成为行业主流趋势,众多传统会议设备品牌均推出多款通话降噪产品,如会议宝、带通话降噪的蓝牙音箱等。从当前市场情况看,产品仍集中在高端、专业领域,属于大众的消费级应用仍是个具有极大开发前景的蓝海市场。

笔者正是在行业向好的背景下接到了开发会议一体机的研发任务。会议一体机设计开始时的参考就是笔记本和平板。这类平板式设备集成了摄像头、麦克风、喇叭、屏幕等外设,融各种会议设备于一体,看起来完全满足会议一体机的要求。但是,笔者做过很多传统会议设备,使用传统会议设备开会的体验完全碾压笔记本或平板。以笔记本为例,差别在以下几点:

1、传统会议接大屏,视场开阔,双流高清,视频质量高。笔记本摄像头就差得远,视频质量不高,视场角窄,没有接外部视频源的能力。

2、传统会议以room会议为主,音响的功率高,声音近场能达到90分贝,远场也能保证80分贝,不论远近都能听的很清楚。笔记本喇叭以音乐播放为主,音腔小,低音表现力差。

3、传统会议使用麦克风,声音信噪比非常高,多人参会时,每个说话人的口音、情绪都能准确辨识。笔记本内置麦克风拾音主要是近场,拾音距离比较近,噪声比较大。

4、传统会议支持多路语音,本地声音和多方语音可以混音。笔记本只能对多方语音混音,无法对 本地视频声音混音。

在上面的几条中,与专业级的会议效果相比,这类平板式设备进行线上会议时最让人感到疲惫的是摆脱不掉的嘈杂噪声,时常发生的刺耳啸叫,生硬的话音,开会时间一长,体验真的是头昏脑涨。因此,要让会议一体机达到专业的会议效果,最重要的需求就是专业级的音效。因此,研发的第一个挑战就来了,视频会议中语音必须要清晰、舒适,而如何保证清晰、舒适的语音呢?

笔者从事多年视频会议终端的研发多年,按理说答案很清楚,只要重放的声音是干净的人声,效果就会非常好。从技术上实现上来说就是好的麦克风,好的喇叭,好的音腔,良好减振效果的稳定底座,功率带宽越宽越好的放大器等等硬件,还有总所周知的ANS、AEC、AGC、EQ的通用算法,把这些组合起来就ok了。

但是笔者很快就栽了一个跟头,这个跟头就是降噪处理。传统的降噪处理的目的就是提高信噪比。当笔者把提高信噪比后的声音,在设备上以90~100分贝的外放后,得到的评价是机械、金属,突发的声音刺耳,结论是无法接受。而传统的视频会议终端在近距离低功率的喇叭放音或耳机放音时的感受则非常好。不同点在哪里呢?

1、传统会议终端的麦克风指向性好,拾音距离比较近,声音干净,信噪比高。而会议一体机需要远距离拾音,空间中的噪声具有空间均匀性,而人声随着距离增加指数衰减,信噪比迅速下降。同样的为保证远距离拾音,无人发声时,噪声也全盘照收,声音不干净。而传统的降噪算法本质上是参考背景噪声进行降噪,背景噪音越大,话音的降噪力度就越大。

2、当远场拾音时,喇叭以90~100分贝的功率放音时,本地播放的声音将超过到达麦克风的话音30~40分贝。这限制了对麦克风信号的增益,因为量化范围的上限被播放的声音限制了,这导致量化噪声加大。

3、当噪声不可避免的被采集到时,却都很难找到一种统一的明确的可量化的描述,这给语音降噪带来了极大的局限。一般的,对于有明显统计特征的噪声,目前的语音降噪有理论可行和实际效果较好的算法。其主要的方法是利用噪声的统计特征估计出噪声,然后从带噪语音中减去噪声成分进而获得纯净的语音。目前比较成功的算法是基于最大似然比的噪声估计,但是这种算法假定了噪声功率谱密度为高斯分布,显然有很大的局限性。而突发的、变频的噪声是无法用此类算法精准估计和消除的。

4、重现空间声场时要求低音丰满柔和,中低音浑厚有力,中高音明亮透彻,高音纤细洁净,同时人的听觉系统处在空间声场中能够轻易的把声源从嘈杂的环境中分离出来。这种现象表明,声音仅仅是信噪比高是不够的,即便可懂度很高,如果声音不够平衡,听起来也会非常的不舒适;而信噪比不高也不一定造成较差的体验。

分析了这些差别,笔者才认识到传统的降噪算法可能解决不了新的问题了,传统算法通过统计的方法对噪声进行估计,并可以对稳态噪声起到比较好的降噪作用,但是在非稳态噪声和瞬态噪声等噪声类型下,传统降噪算法往往不能起到比较好的效果,特别的是传统降噪算法可能保证不了声音的空间感,而这种空间感在会议一体机的体验中至关重要。

笔者不得已把目光转向了最近几年比较火的 AI 技术。经过资料收集发现在降噪等音频处理领域,都出现了很多基于 Artificail Intelligence(AI)或者说基于人工神经网络模型的降噪算法。这些 AI 算法在降噪能力上较传统算法都有很大的提升。先不考虑设备算力、存储体积等条件的限制,先试试。

先来看看 AI 降噪算法是如何一步步实现的 ,首先得知道AI 模型的构建普遍采用大量数据训练的方式,来让模型学习到数据内隐含的信息,这就是所谓的机器学习。在降噪这个领域,模型的输入是带噪的语音信号,模型的输出是纯净的语音信号,通过大量的这样成对的带噪和纯净的语音数据,来训练 AI 模型,使其具有降噪的能力。其次,得知道常见的 AI 降噪模型的结构,以及 AI 降噪模型的训练方法。AI 模型常采用人工神经网络来模拟人脑神经的记忆和处理信号的能力。常见的人工神经网络类型有深度神经网络(Deep Neural Network,DNN)、卷积神经网络(Convolutional Neural Network,CNN)、循环神经网络(Recurrent Neural Network,RNN)等。

好了,学习结束,两个结论:

1、AI降噪的模型很多,开源的也不少,如果不是太熟悉神经网络优化的,挑一个实时性好的模型就可以了。先相信这些模型的水平是比较高的,要不也不会在行业里扬名。

2、大数据的训练必不可少。要想效果好,得收集自己的数据。

笔者的做法很简单,拿设备去实际环境中采集各种噪声,在静音房里采集标准的人声,然后和开源的样本放到一起进行训练。这样训练的好处是既保证了模型的泛化能力,也提高了模型对设备实际采集声音的处理效果。神经网络的特点是你想要什么效果就得给什么样的数据,所以静音房就仅仅是比较安静能将外面噪声隔音的房间,和真实的房间的空间差不多。我们是图1那种,不是图2那种消声室。

![图片[1]-基于神经网络算法的TeamFree会议一体机降噪实战-卡咪卡咪哈-一个博客](http://p2.itc.cn/images01/20230407/87aa2da921fe4cc48fcff7fc670ac070.png)

图 1静音室 图 2 消声室

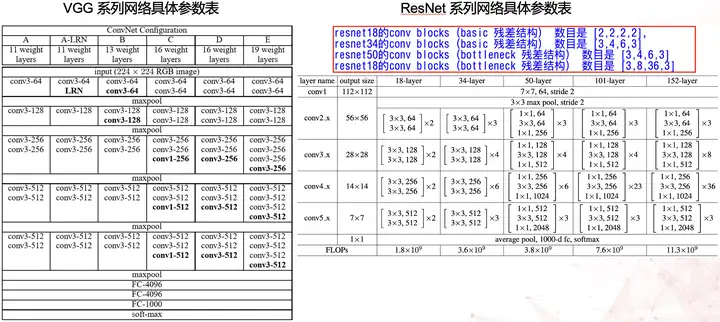

数据有了,训练完了,把训练好的神经网络权重和偏差更新到模型中,看看 AI 降噪算法效果如何。

![图片[2]-基于神经网络算法的TeamFree会议一体机降噪实战-卡咪卡咪哈-一个博客](http://p5.itc.cn/images01/20230407/34bde4b19ee148088a81ab4ad4faf74f.png)

图 3 降噪后语谱 图 4降噪前语谱

用神经网络降噪的效果主要有三个优点:

1、降噪效果与背景噪声的大小没有强相关性,不会因为噪声大降噪时对话音的损害就大。

2、即便没有明显的统计学特征也能去除特定的噪声,如上图被黑线圈住的噪声分量。

3、纯噪声去除的彻底。

经过实战,笔者一步步的实现了在实时音频互动场景中,解决降噪算法的部署难题,达到了满意的效果。更多体验请尝试一下TeamFree会议一体机吧。返回搜狐,查看更多

责任编辑:

暂无评论内容