博而不士的开源大语言模型巡展第六站-GPT4All

大型语言模型(Large Language Model,LLM)是一种利用深度学习技术来处理自然语言的人工智能模型。它们可以根据给定的文本生成相关的文本,从而实现各种任务,如问答、写作、摘要、翻译、对话等。近年来,随着数据量和计算能力的增加,LLM的规模和性能也不断提升,出现了一些令人惊叹的成果。

然而,LLM也面临着一些严峻的挑战。首先,LLM需要大量的GPU或TPU等高端硬件来训练和运行,这使得它们只能由少数拥有强大计算资源的机构或个人所使用。例如,GPT-3模型有1750亿个参数,需要花费数百万美元来训练。其次,LLM通常需要通过互联网来访问云端服务器,这会导致用户的隐私和数据安全受到威胁。例如,GPT-3模型只能通过OpenAI提供的API来使用,用户必须将自己的输入和输出数据发送给OpenAI。再次,LLM往往是通用的,不能根据用户的需求和偏好进行定制和优化,这会影响它们的效果和体验。例如,GPT-3模型虽然可以处理各种任务,但是它并不擅长特定领域或场景的问题。

针对这些问题,有没有一种方法可以让普通用户在自己的电脑上运行强大和定制的LLM呢?答案是肯定的。GPT4All项目就是为此而生的。GPT4All项目是一个开源软件生态系统,它允许任何人在日常硬件上训练和部署本地运行、隐私保护、指令调优的大型语言模型。在本文中,我们将详细介绍GPT4All项目的目标、特点、优势、组件、模型等方面,并展望它的未来发展和应用场景。

GPT4All项目设定了一个简单而宏大的目标:构建一个开放的平台,使任何人或企业都能自由地使用、分发和构建优质的、基于指令调优的助理式大型语言模型。为了实现这个目标,GPT4All项目具有以下几个特点和优势:

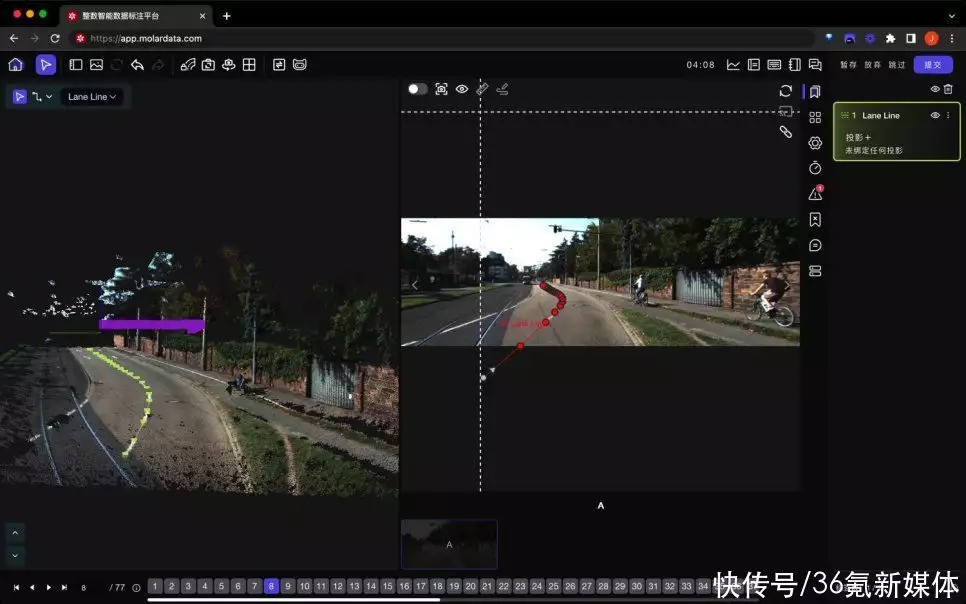

本地运行:GPT4All项目不需要GPU或互联网,只需要一台普通的电脑就可以运行大型语言模型。这是通过一种称为神经网络量化(Neural Network Quantization)的技术实现的。神经网络量化是一种压缩神经网络参数和激活值的方法,可以显著降低神经网络运行时所需的内存和计算资源。通过神经网络量化,GPT4All项目可以将原本需要30GB以上显存才能运行的大型语言模型压缩到3GB-8GB左右,并在普通CPU上实现高效推理。开源生态系统:GPT4All项目是一个开源软件生态系统,它包括后端、绑定、API、聊天客户端等多个组件。后端是负责管理和执行大型语言模型推理的核心部分,它提供了一个通用、性能优化的C API。绑定是将C API绑定到其他高级编程语言(如Python、Go等)的部分。API是提供REST API接口来获取大型语言模型生成结果和嵌入向量(Embedding)的部分。聊天客户端是一个跨平台(OSX、Windows、Ubuntu)的聊天应用程序,它是使用大型语言模型最简单方便的方式。指令调优:GPT4All项目采用了一种称为指令调优(Instruction Tuning)的方法来训练和使用大型语言模型。指令调优是一种利用自然语言指令来控制大型语言模型行为和输出格式的方法。通过指令调优,用户可以根据自己的需求和偏好来定制大型语言模型,并实现各种任务。多种模型支持:GPT4All项目目前支持三种变体(Variant)的Transformer神经网络架构:LLaMa、GPT-J和MPT 。任何使用这些架构训练出来的模型都可以被量化并在GPT4All项目中运行。用户也可以通过贡献后端代码来添加新的变体支持。

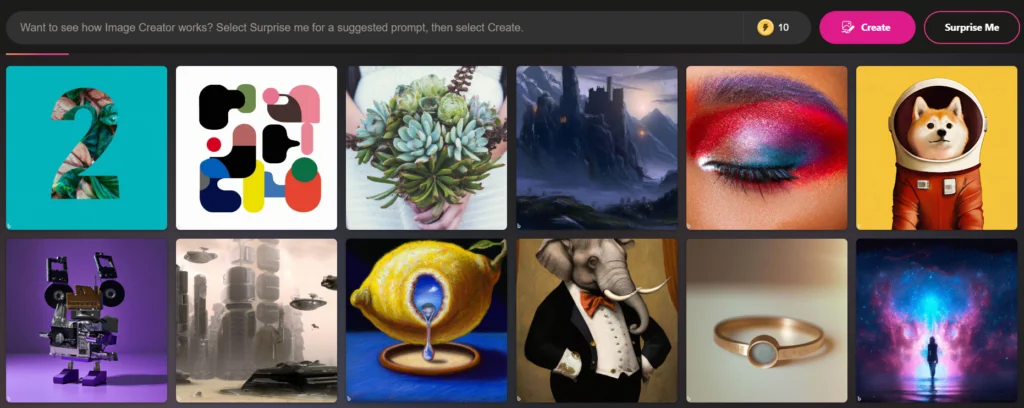

GPT4All项目提供了一系列预训练好并经过量化处理的大型语言模型供用户下载和使用。这些模型有不同的规模(从6B到13B参数)、风格(从通用到专业)、性能(在不同任务上有不同的表现)和特点(如指令调优、隐私保护等)。用户可以根据自己的喜好和目标来选择合适的模型,并在聊天客户端中切换和比较它们。以下是一些GPT4All项目提供的模型的简介:

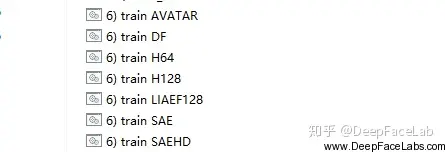

LLaMa:LLaMa是一种基于Transformer的大型语言模型,它使用了一种称为Lora(Layer-wise Recomposition)的技术来提高模型的效率和稳定性。Lora是一种将Transformer层分解为多个子层,并在每个子层上应用不同的注意力机制(Attention Mechanism)的方法。这样可以减少计算量,提高并行性,降低内存消耗,增强模型的泛化能力和鲁棒性。GPT4All项目提供了两个规模的LLaMa模型:LLaMa 7B和LLaMa 13B。GPT-J:GPT-J是一种基于Transformer的大型语言模型,它使用了一种称为Rotary Position Embedding(RPE)的技术来处理长序列文本。RPE是一种将位置信息编码为旋转矩阵,并与输入向量相乘的方法。这样可以避免使用绝对位置编码(Absolute Position Encoding),从而减少参数量,提高效率,增强模型的长期依赖能力和泛化能力。GPT4All项目提供了一个规模的GPT-J模型:GPT-J 6.7B。MPT:MPT是一种基于Transformer的大型语言模型,它使用了一种称为Mixture of Experts(MoE)的技术来提高模型的容量和灵活性。MoE是一种将Transformer层分解为多个专家层,并根据输入向量动态地选择其中一部分专家层进行计算的方法。这样可以增加模型的参数量,提高表达能力,增强模型的多样性和适应性。GPT4All项目提供了三个规模的MPT模型:MPT 7B、MPT Instruct 7B和MPT Chat 7B。

GPT4All项目是一个具有创新意义和实用价值的项目,它为普通用户提供了一个方便而强大的方式来使用大型语言模型。它不仅降低了计算资源和隐私方面的门槛和风险,还提高了可定制性和多样性方面的可能性和潜力。我们期待着GPT4All项目未来能够带来更多惊喜和收获,并为人工智能领域做出更多贡献。

博览AI的奥秘,博学AI的知识,博交AI的朋友,我是博而不士,欢迎加入我的AI探索之旅。关注我,一起玩转AI。

原创性承诺:G3(内容由人工列出提纲,AI对提纲进行扩充内容完成文章)

暂无评论内容