在位于巴黎郊区的法国国家科学研究中心,有一个超级计算中心,内部一排排看起来像黑色冰箱的东西正嗡嗡作响。听着震耳欲聋的 100 分贝的声音,就像是参加了一场人工智能研究的摇滚音乐会。

这些嗡嗡作响的东西是超级计算机的一部分,该超级计算机花了 117 天时间开发了一种名为 BLOOM 的新大型语言模型(LLM,Large Language Model),它的创造者希望这展现了一条与人工智能常见开发方式完全不同的道路。

BLOOM 的英文全名代表着大科学、大型、开放科学、开源的多语言语言模型。

与其他更著名的大型语言模型,如 OpenAI GPT-3 和谷歌的 LaMDA,它的设计尽可能透明,研究人员会分享训练数据的细节,开发过程中的挑战,以及性能的评估方式。

OpenAI 和谷歌还没有共享他们的代码,也没有向公众提供他们的模型,外部研究人员对这些模型的训练方式知之甚少。

BLOOM 是去年由 1000 多名志愿研究人员在一个名为“大科学 BigScience”的项目中创建的,该项目由人工智能初创公司 Hugging Face 利用法国政府的资金运作的。该模型于 7 月 12 日正式发布。

研究人员希望开发一种开放获取的大型语言模型,性能足以媲美其他先进的模型,而且还可以推动人工智能开发文化发生转变,并且帮助世界各地的研究人员普及尖端人工智能技术。

BLOOM 模型的最大优势是它的易获取性。它现在已经公开发布了,任何人都可以在 Hugging Face 网站上免费下载。用户有多个语种可选,然后将需求输入到 BLOOM 中,任务类型包括撰写食谱或诗歌、翻译或总结文本,甚至还有代码编程。人工智能开发人员可以在该模型的基础上构建他们自己的应用程序。

BLOOM 拥有 1760 亿个参数(决定输入数据如何转换为输出内容的变量),稍多于拥有 1750 亿个参数的 GPT-3,研究人员称它提供了与其他相同大小的模型相似的准确性和有毒文本水平。对于西班牙语和阿拉伯语等语言来说,BLOOM 是第一个如此规模的大型语言模型。

但即使是该模型的创造者也警告说,它尚未解决困扰大型语言模型的根深蒂固的问题,包括在数据治理和隐私方面缺乏足够的政策指引,以及算法会生成有毒内容,如充斥种族主义或性别歧视的文字。

公开获取

大型语言模型是一种使用了大量数据训练的深度学习算法。它们是人工智能研究中最热门的领域之一。像 GPT-3 和 LaMDA 这样强大的模型,它们生成的文本读起来就像是人类写的,在改变在线信息处理方面有巨大的潜力。

它们可以被用来开发聊天机器人,或者用来搜索信息、筛查在线内容、总结书籍、或者根据提示生成全新的文本。但它们也充满着问题,只需要一点点引导,这些模型就可以生成有毒内容。

这些模型也非常独特。他们需要使用大量昂贵的算力来支撑大量数据的训练,而这只有像谷歌这样的大型科技公司才能负担得起。

大多数开发尖端大型语言模型的大型科技公司都限制了外部人士使用它们,也没有公布有关其模型内部运作的信息,这使得他们很难承担责任。保密性和排他性是 BLOOM 研究人员希望改变的东西。

Meta 已经开始尝试改变现状:2022 年 5 月,该公司发布了自己的大型语言模型,开放式预训练 Transformer (OPT-175B),以及模型的代码和详细说明该模型如何训练的日志。

但使用 Meta 的模型需要提交申请,而且它的许可限制了其用于研究目的。Hugging Face 在开放程度上更进一步,详细介绍其过去一年工作的会议记录被上传到网上,任何人都可以免费下载该模型,并用于研究或构建商业应用程序。

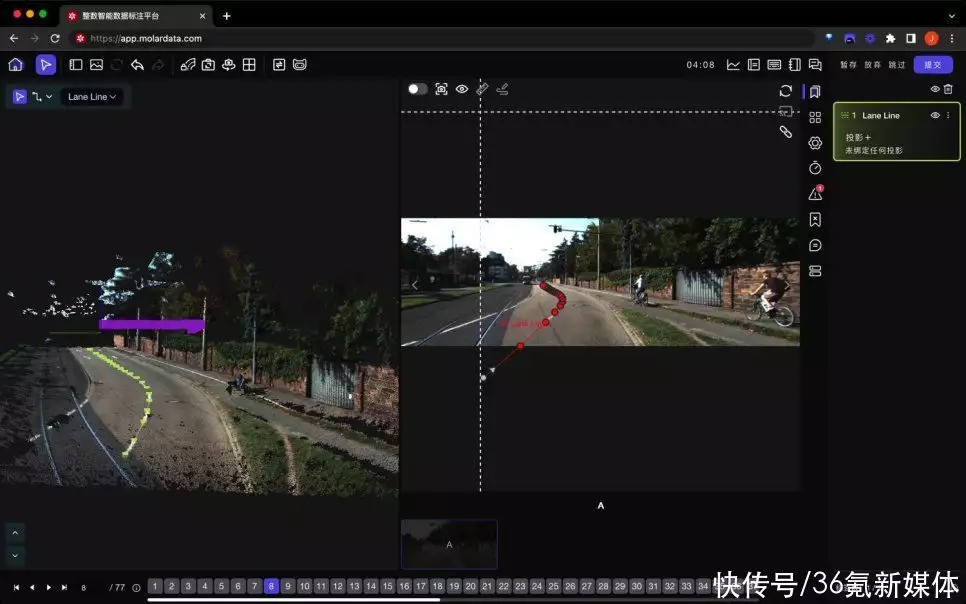

BigScience 项目的一个重点是从一开始就将伦理纳入考量,而不是模型完成之后再考虑。大型语言模型使用从互联网收集到的大量数据进行训练。这可能带来问题,因为这些数据集包含了大量的个人信息,而且经常展现出危险的偏见。

研究人员专门为大型语言模型开发了数据治理结构,这使它更清楚正在使用的数据的类型和来源,它的数据集来自世界各地,而且无法从网上轻易获得。

该组织还公布了“负责任的人工智能许可”这一全新概念。它类似于服务条款协议,目的是防止执法或卫生保健等高风险部门使用其技术伤害、欺骗、剥削或冒充公众。

参与该项目并创建了该许可的人工智能研究员丹尼希·康楚科特(Danish Contractor )表示,该许可是在法律完备之前的自我约束性实验。但归根结底,没有什么能阻止任何人滥用 BLOOM。

这个项目从一开始就有专属的伦理指导原则。

Hugging Face 的伦理学家贾达·皮斯蒂利(Giada Pistilli)起草了 BLOOM 的伦理准则,作为模型开发的原则。

例如,它强调了从不同的背景和地点招募志愿者,确保普通人能够轻松地重现该项目的研究结果,还有公开公布其研究结果。

一同出发

这一系列指导原则使 BLOOM 和今天其他可用大型语言模型存在的一个主要区别:该模型可以理解多达 46 种人类语言,包括法语、越南语、普通话、印度尼西亚语、加泰罗尼亚语、13 种印度语言(如印地语)和 20 种非洲语言。超过 30% 的训练数据是英文的。该模型还可以理解 13 种编程语言。

这在英语占主导地位的大型语言模型世界中是非常不寻常的。这是通过互联网抓取数据而建立模型的另一个结果:英语是互联网上最常用的语言。

BLOOM 能够改善这种情况的原因是,该团队召集了来自世界各地的志愿者,用其他语言构建合适的数据集,即使这些语言在互联网上十分小众。

Hugging Face 的实习研究员克里斯·易麦吉(Chris Emezue)表示,该组织会发起研讨会并与非洲人工智能研究人员搜寻数据集,如从地方当局或大学寻找用于训练非洲语言模型的记录。

容纳如此多不同的语言可能对贫穷国家的人工智能研究人员有巨大帮助,因为他们通常很难获得自然语言处理渠道,因为要使用大量昂贵的算力。

允许他们跳过开发和训练模型的昂贵部分,以便专注于构建应用程序和为其母语语言微调模型。

“如果你想把非洲语言纳入未来的自然语言处理过程中……在训练语言模型时加入它们是一个非常好的和重要的步骤,”克里斯 表示。

小心操作

斯坦福大学研究中心负责基础模型的研究中心主任佩西·梁(Percy Liang)表示,BigScience 在建立社区建设方面做的工作是“非凡的”,它从一开始就考虑伦理和治理的方法是经过深思熟虑的。

然而,Liang 并不认为这会让大型语言模型的开发发生重大变化。“OpenAI、谷歌和微软仍遥遥领先,”他说。

最终, BLOOM 仍然是一个大型语言模型,因此它仍然伴随着所有相关的缺陷和风险。像 OpenAI 这样的公司还没有向公众发布他们的模型或代码,因为他们认为,掺杂其中的性别歧视和种族主义语言让模型变得不适合公开。

BLOOM 也可能包含不准确和有偏见的语言,但人工智能研究员玛格丽特·米切尔(Margaret Mitchell)认为,由于模型的一切都是公开的,人们将能够探索模型的优点和缺点。

项目对人工智能的最大贡献可能不是 BLOOM,但它的志愿者正在参与的众多衍生研究项目。例如,这些项目可以增强模型的隐私证书,并提出在不同领域使用该技术的方法,如生物医学研究。

“一种新的大型语言模型不会改变历史的进程,”研究员蒂文·勒斯科(Teven Le Scao )说,他共同领导了 BLOOM 的训练。“但有一个好的开放语言模型,人们对其可以进行研究,这会产生强大的长期影响。”

当谈到大型语言模型的潜在危害时,“潘多拉的盒子已经完全打开了,”勒斯科说。“你能做的最好的事情就是为研究人员创造研究的最佳条件。”

支持:Ren

参考资料:

https://www.technologyreview.com/2022/07/12/1055817/inside-a-radical-new-project-to-democratize-ai/

暂无评论内容