Hadoop 2.x 中的多节点群集

从我们之前的Hadoop教程系列博客中,我们学习了如何设置 Hadoop单节点集群。现在,我将展示如何设置Hadoop多节点集群。Hadoop 中的多节点集群在分布式 Hadoop 环境中包含两个或多个 DataNode。这实际上在组织中用于存储和分析其PB和EB的数据。学习设置多节点集群可以让您更接近急需的 Hadoop 认证。

在这里,我们采用两台机器——主机器和从机。在两台计算机上,数据节点都将运行。

让我们从Hadoop中多节点集群的设置开始。

实验环境

- Cent OS 6.5

- Hadoop-2.7.3

- JAVA 8

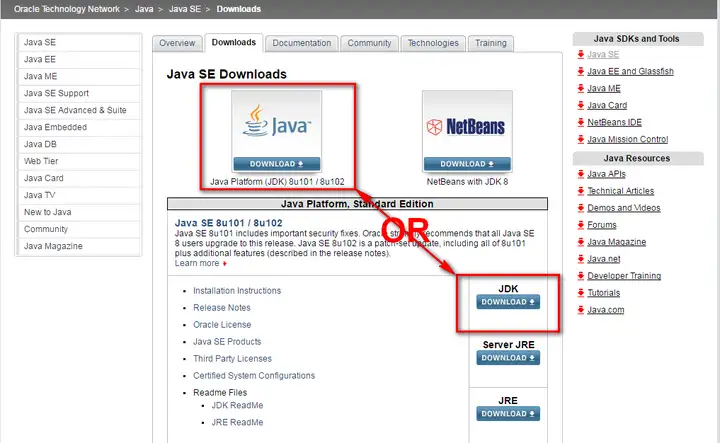

- SSH

在Hadoop中设置多节点集群

我们有两台带有IP的机器(主机器和从机):

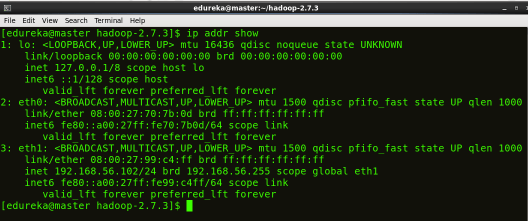

主IP:192.168.56.102

从属IP:192.168.56.103

第 1 步:检查所有计算机的 IP 地址。

命令:ip addr show(你也可以使用 ifconfig 命令)

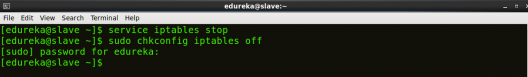

第 2 步:禁用防火墙限制。

命令:service iptables stop

命令: sudo chkconfig iptables off

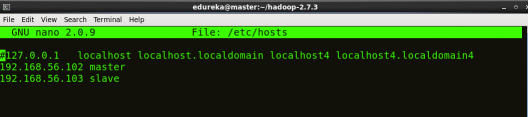

第 3 步:打开主机文件以添加主节点和数据节点及其各自的 IP 地址。

命令: sudo nano /etc/hosts

相同的属性将显示在主主机和从主机文件中。

第 4 步:重新启动 sshd 服务。

命令: service sshd restart

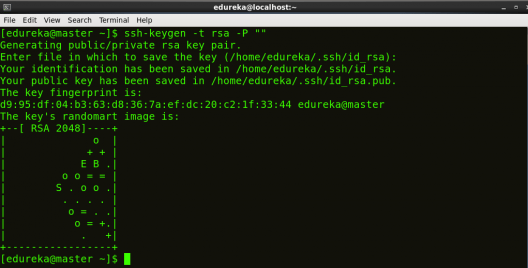

第 5 步:在主节点中创建 SSH 密钥。(当它要求您输入文件名以保存密钥时,按回车键按钮)。

命令: ssh-keygen -t rsa -P “”

第 6 步:将生成的 ssh 密钥复制到主节点的授权密钥。

命令: cat $HOME/.ssh/id_rsa.pub >> $HOME/.ssh/authorized_keys

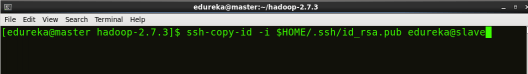

第 7 步: 将主节点的 ssh 密钥复制到从节点的授权密钥。

命令: ssh-copy-id -i $HOME/.ssh/id_rsa.pub edureka@slave

第 8 步:单击此处下载 Java 8 软件包。将此文件保存在主目录中。

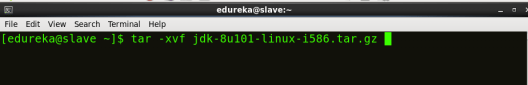

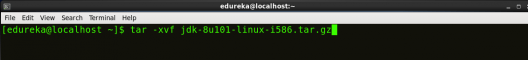

第 9 步:在所有节点上解压缩 Java Tar 文件。

命令: tar -xvf jdk-8u101-linux-i586.tar.gz

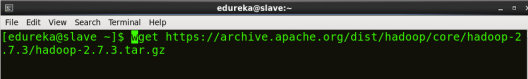

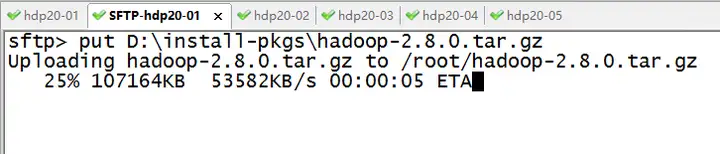

步骤10: 在所有节点上下载 Hadoop 2.7.3 软件包。

命令:wget https://archive.apache.org/dist/hadoop/core/hadoop-2.7.3/hadoop-2.7.3.tar.gz

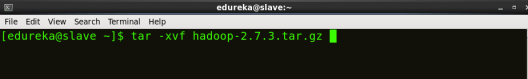

步骤11: 在所有节点上提取 Hadoop tar 文件。

命令: tar -xvf hadoop-2.7.3.tar.gz

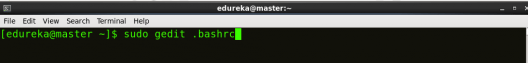

第12步: 在所有节点上的 bash 文件 (.bashrc) 中添加 Hadoop 和 Java 路径。

打开.bashrc文件。现在,添加Hadoop和Java Path,如下所示:

命令: sudo gedit .bashrc

然后,保存 bash 文件并关闭它。

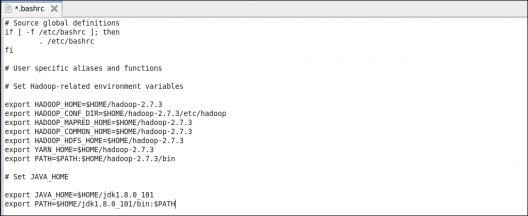

要将所有这些更改应用于当前终端,请执行 source 命令。

命令: source .bashrc

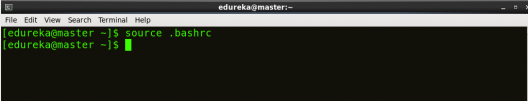

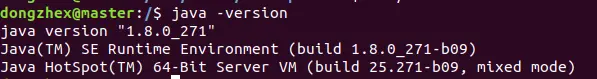

要确保 Java 和 Hadoop 已正确安装在您的系统上,并且可以通过终端访问,请执行 java 版本和 hadoop版本命令。

命令: java 版本

命令:哈多普版本

现在编辑hadoop-2.7.3/etc/hadoop目录中的配置文件。

第 13 步:在主机器和从机中创建主文件并进行如下编辑,如下所示:

命令:sudo gedit masters

第14步:在主机器中编辑从属文件,如下所示:

命令: sudo gedit /home/edureka/hadoop-2.7.3/etc/hadoop/slaves

步骤15:编辑从属机中的从站文件,如下所示:

命令: sudo gedit /home/edureka/hadoop-2.7.3/etc/hadoop/slaves

步骤16:在主计算机和从属计算机上编辑core-site.xml如下所示:

命令: sudo gedit /home/edureka/hadoop-2.7.3/etc/hadoop/core-site.xml

|

1

2

3

4

5

6

7

8

|

<?xml version="1.0" encoding="UTF-8"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration><property><name>fs.default.name</name><value>hdfs://master:9000</value></property></configuration> |

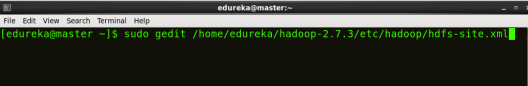

第 7 步:在 master 上编辑 hdfs-site.xml,如下所示:命令:sudo gedit /home/edureka/hadoop-2.7.3/etc/hadoop/hdfs-site.xml

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

|

<?xml version="1.0" encoding="UTF-8"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration><property><name>dfs.replication</name><value>2</value></property><property><name>dfs.permissions</name><value>false</value></property><property><name>dfs.namenode.name.dir</name><value>/home/edureka/hadoop-2.7.3/namenode</value></property><property><name>dfs.datanode.data.dir</name><value>/home/edureka/hadoop-2.7.3/datanode</value></property></configuration> |

第18步:在从属机器上编辑 hdfs-site.xml,如下所示:

命令: sudo gedit /home/edureka/hadoop-2.7.3/etc/hadoop/hdfs-site.xml

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

<?xml version="1.0" encoding="UTF-8"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration><property><name>dfs.replication</name><value>2</value></property><property><name>dfs.permissions</name><value>false</value></property><property><name>dfs.datanode.data.dir</name><value>/home/edureka/hadoop-2.7.3/datanode</value></property></configuration> |

步骤19:从配置文件夹中的模板复制映射站点.xml并在主机器和从属机器上编辑映射站点,如下所示:

命令: cp mapred-site.xml.template mapred-site.xml

命令: sudo gedit /home/edureka/hadoop-2.7.3/etc/hadoop/mapred-site.xml

|

1

2

3

4

5

6

7

8

|

<?xml version="1.0" encoding="UTF-8"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration><property><name>mapreduce.framework.name</name><value>yarn</value></property></configuration> |

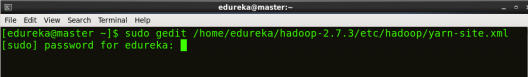

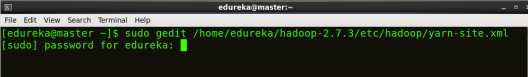

步骤20:在主机器和从机上编辑yarn-site.xml如下所示:

命令: sudo gedit /home/edureka/hadoop-2.7.3/etc/hadoop/yarn-site.xml

|

1

2

3

4

5

6

7

8

9

10

11

12

|

<?xml version="1.0" encoding="UTF-8"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><property><name>yarn.nodemanager.auxservices.mapreduce.shuffle.class</name><value>org.apache.hadoop.mapred.ShuffleHandler</value></property></configuration> |

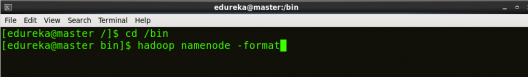

第 21 步:格式化名称节点(仅在主计算机上)。

命令:hadoop namenode -format

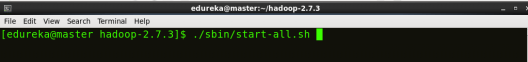

第 22 步:启动所有守护进程(仅在主计算机上)。

命令: ./sbin/start-all.sh

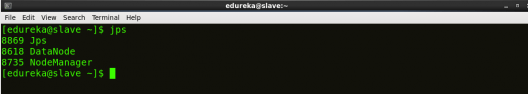

步骤23:检查在主机器和从机上运行的所有守护程序。

命令: jps

在主服务器上

在从属

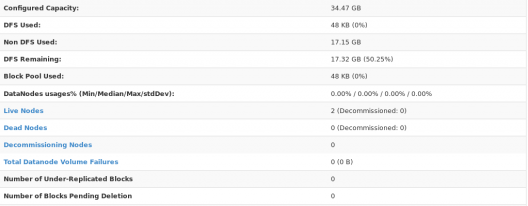

最后,打开浏览器并转到主机器上的 master:50070/dfshealth.html,这将为您提供 NameNode 界面。向下滚动并查看活动节点的数量,如果是 2,则表示您已成功设置多节点 Hadoop 集群。如果不是 2,您可能错过了我上面提到的任何步骤。但无需担心,您可以返回并再次验证所有配置以查找问题,然后更正它们。

在这里,我们只有 2 个数据节点。如果需要,您可以根据需要添加更多数据节点,请参阅我们关于在 Hadoop 集群中调试和停用节点的博客。

我希望您能成功安装Hadoop多节点集群。如果您遇到任何问题,可以在下面发表评论,我们会尽快回复。在我们Hadoop教程系列的下一篇博客中,您将学习一些重要的HDFS命令,并且可以开始使用Hadoop。

暂无评论内容